LLaMA是Meta AI公司于2023年2月发布的大型语言模型。作为该系列的初代模型,Llama 是一个纯粹的基座语言模型,设计目标是提供一个开放且高效的通用语言理解与生成平台。共有 7B、13B、33B、65B(650 亿)四种版本。

关于训练集,其来源都是公开数据集,无任何定制数据集,保证了其工作与开源兼容和可复现。整个训练数据集在 token 化之后大约包含 1.4T 的 token。其中,LLaMA-65B 和 LLaMA-33B 是在 1.4万亿个 token 上训练的,而最小的模型 LLaMA-7B 是在 1万亿个 token 上训练的。

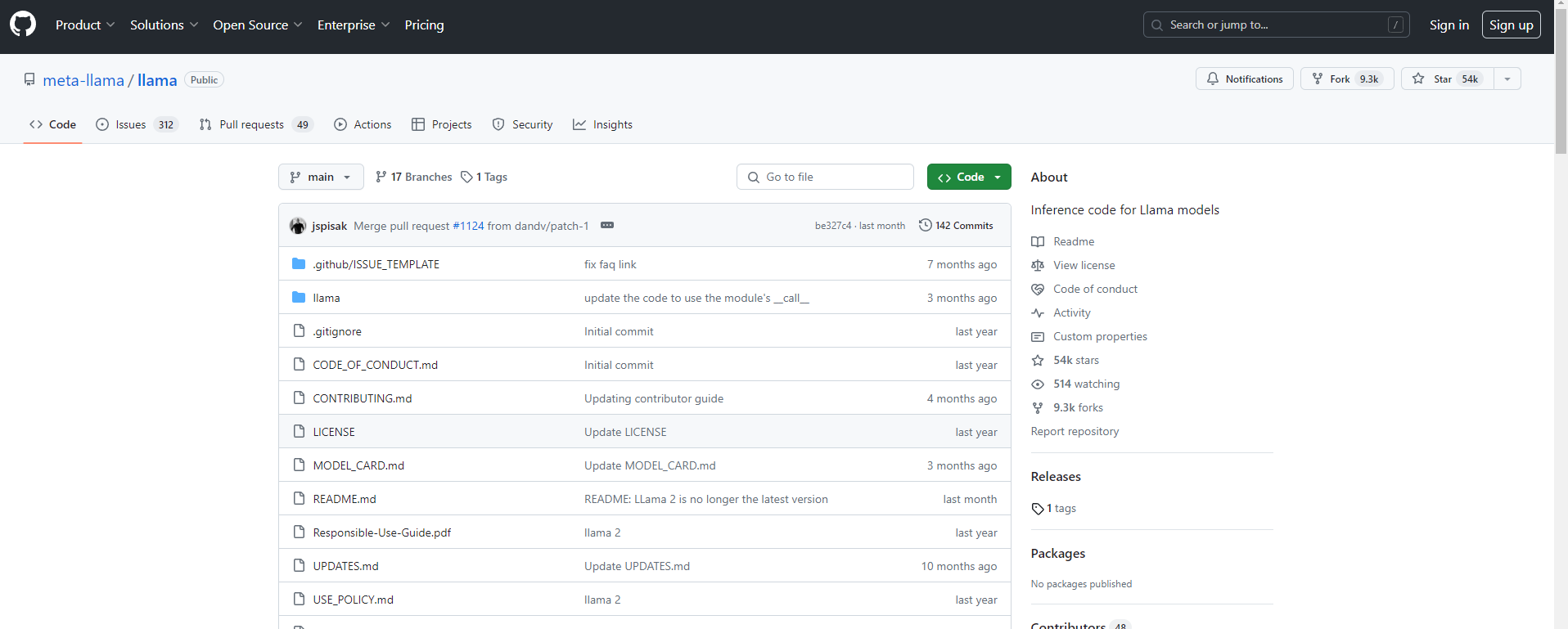

关于模型性能,LLaMA 的性能非常优异:具有 130 亿参数的 LLaMA 模型「在大多数基准上」可以胜过 GPT-3( 参数量达 1750 亿),而且可以在单块 V100 GPU 上运行;而最大的 650 亿参数的 LLaMA 模型可以媲美谷歌的 Chinchilla-70B 和 PaLM-540B。虽然其他强大的大语言模型通常只能通过有限的API访问,但Meta在非商业许可的情况下发布了LLaMA的模型权重,供研究人员参考和使用。

@版权声明:部分内容从网络收集整理,如有侵权,请联系删除!

川公网安备 123456789号

川公网安备 123456789号