上演神仙打架,OpenAI认为大模型“力大砖飞”,谷歌却有不同意见

近年来,随着模型规模的日益扩大,业内普遍存在着“力大砖飞”的观念,即认为更大的模型会带来更好的性能。然而,这一观点并非无懈可击。OpenAI在其技术报告中确实提到了他们最大的模型Sora能够生成高保真视频,并暗示了扩展视频生成模型是构建物理世界通用模拟器的一条有前景的道路。尽管如此,OpenAI作为Scaling laws的拥趸,其理论是否真的能在所有情况下都产生奇迹般的效果呢?

事实上,谷歌最新的研究给出了不同的结论。谷歌研究院与约翰霍普金斯大学的联合研究发现,在潜在扩散模型(LDMs)的情境下,模型的大小并非总是决定性能的关键因素。这一结论与OpenAI等先前的研究在缩放定律上的观点存在显著差异。缩放定律,源自OpenAI在2020年的一篇论文,主要阐述了模型效果与规模大小、数据集大小及计算量之间的紧密关系,而相对弱化了模型结构的影响。然而,谷歌的研究却指出,在计算资源有限的情况下,对于LDMs而言,增加数据集的大小比增加模型参数量更为有效。

这一争议并非首次出现。在缩放定律的研究中,OpenAI和DeepMind等机构的观点就存在分歧。OpenAI倾向于认为模型参数量在性能提升中占据更重要的地位,而DeepMind则认为数据集大小和模型参数量应同步增长。尽管这些争议在LLM(大语言模型)领域已经得到了广泛的讨论,但谷歌的研究将焦点转向了图像生成模型,特别是LDMs。

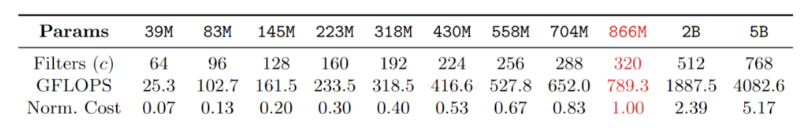

作者设计了11个文本生成图像的LDM,其参数量从3900万到50亿不等。如下图所示,第一行是模型参数量,第二行是其中Unet模型的第一层宽度,第三和四行分别是模型的GFLOPS(运行一次前向传播和反向传播所需的计算量)和花费(相对于原始866M模型的花费,即假设866M模型的花费为1.00)。

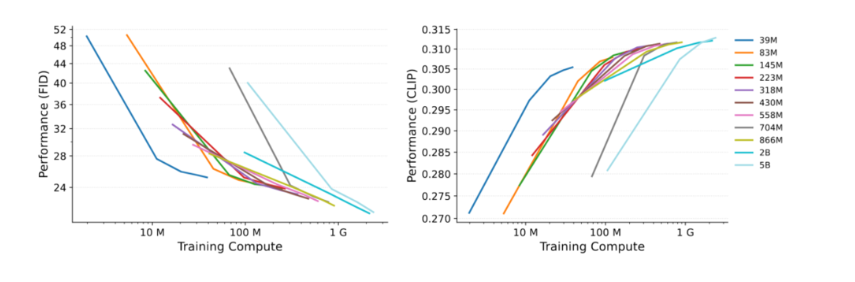

众所周知,模型的总计算量等于训练步骤和GFLOPS的乘积,所以在总计算量恒定的约束下,越大的模型能得到的训练步骤就越少,所以是模型大比较重要还是训练步骤多比较重要呢?

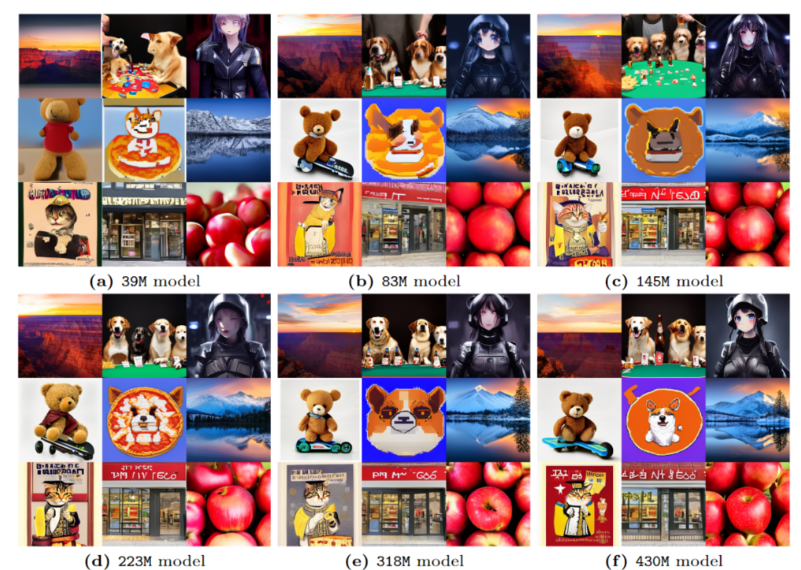

训练步骤多比较重要。在计算资源有限时,较小的模型(训练步骤多)可以胜过较大的模型(训练步骤少);模型大小以及训练步骤的选择要和计算资源适配。下面给出了一个定性的示例,可以看出小模型的效果更好一些。

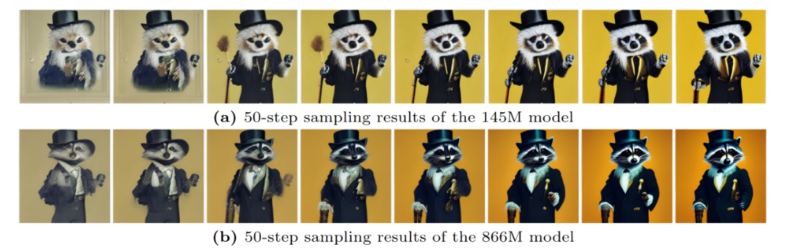

但当训练步骤恒定时,依然是模型越大越好,下面给出了一个例子:训练步骤恒为500k,不同体积模型的生成效果。

此外,研究还发现,在训练步骤恒定的情况下,模型规模越大,生成效果通常越好。然而,这并不意味着在所有情况下大模型都是最优选择。例如,在超分辨率任务中,大模型展现出更强的细节生成能力,但在其他任务中,小模型可能因训练步骤更多而表现出更好的性能。

通过对比实验发现,在计算资源受限时,增加数据集的大小可以带来更显著的性能提升,而不是简单地增大模型规模。这一发现对于理解LDMs的性能提升途径具有重要的指导意义。

值得注意的是,尽管模型规模在一定程度上影响了生成效果,但不同体积模型的CFG(Classifier-Free Guidance)相关性却基本一致。这表明,在调整CFG速率以优化生成效果时,模型规模并不是一个决定性因素。

综上所述,关于模型规模和性能之间的关系并非简单的一成不变。在实际应用中,我们需要根据具体的任务和资源条件来选择合适的模型规模和训练策略。谷歌的最新研究为我们提供了有益的启示,即在计算资源有限的情况下,通过优化数据集大小而非单纯增大模型规模,可能是一种更为有效的提升性能的途径。未来,随着技术的不断进步和研究的深入,我们有望更深入地理解并优化模型的性能表现。

川公网安备 123456789号

川公网安备 123456789号