一代新王换旧王!革命新架构掀翻Transformer

Transformer王座即将被取而代之!

来自Meta、南加州大学(USC)、CMU和UCSD的顶尖研究团队最近提出了一个革命性的神经网络架构——Megalodon(巨齿鲨)。这一架构专为处理“无限上下文”长度的LLM预训练及推理设计,标志着AI领域的一次重大突破。

传统的Transformer架构在处理长上下文时,受到二次复杂度和长度外推能力弱的限制。虽然已有次二次方解决方案,如线性注意力和状态空间模型,但它们在预训练效率和下游任务准确率上往往难以匹敌Transformer。Megalodon的出现,正是为了克服这些限制,实现真正的无限上下文处理。、

值得一提的是,Megalodon不仅解决了无限上下文的问题,还实现了高效训练和高效推理。在与Llama 2的直接比较中,Megalodon在处理70亿参数和2万亿训练token的任务上,不仅训练效率更高,而且准确率也超过了Transformer。这一成就令人瞩目,标志着AI领域计算效率和性能的新时代的开启。

许多网友和业内专家对Megalodon的发布表示了极大的关注和认可。他们认为,无限上下文长度的处理能力是游戏规则的改变者,将释放出LLM的无限潜力。一些初创公司的CEO甚至表示,这是自GPT-3发布以来最大的里程碑,对AGI的发展具有重要意义。

还有人认为「无限上下文长度,绝对是游戏规则的改变者」!

更有甚者,初创公司CEO称,「这是自GPT-3发布以来最大的里程碑,但却没有任何动静?!

Megalodon就相当于是AGI的基础」。

「Meta的Megalodon是一项突破性进展,对AGI具有重要意义。它的无限上下文长度模拟了人类的认知,实现了无缝任务切换」。

论文作者Hao Zhang表示,这是一种全新替代Transformer的架构。

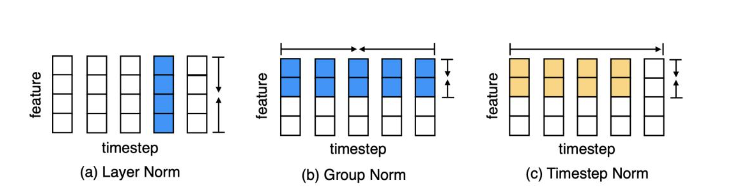

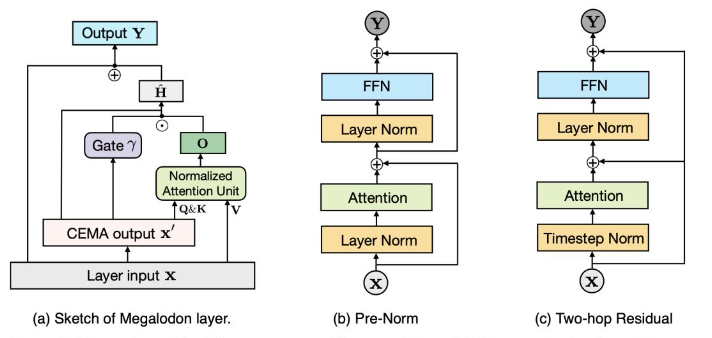

那么,Megalodon是如何实现这一卓越表现的呢?据了解,它基于MEGA架构进行了改进,并新增了多个技术组件。其中,复杂指数移动平均(CEMA)组件和时间步归一化层是其中的关键创新。CEMA扩展了MEGA中使用的多维阻尼指数移动平均方法到复数域,增强了模型处理复杂数据的能力。而时间步归一化层则将传统的组归一化技术扩展到自回归序列建模任务中,实现了有效的归一化。

在具体实验评估中,Megalodon在多个任务上表现出色。无论是大规模LLM预训练还是序列建模基准任务,Megalodon都展现了优异的数据学习效率和计算效率。这一成果充分证明了Megalodon在处理无限上下文长度方面的强大能力。

总的来说,Megalodon的提出为AI领域带来了新的希望和机遇。它解决了传统Transformer架构在处理长上下文时的限制,实现了真正的无限上下文处理。同时,它还实现了高效训练和高效推理,为AI应用的发展提供了强大的支持。相信在未来,Megalodon将在AI领域发挥越来越重要的作用,推动技术的不断进步和创新。

川公网安备 123456789号

川公网安备 123456789号