AI大模型竞赛升温,DeepSeek与英伟达争相开源高性能模型

在AI大模型领域的激烈竞争中,比拼性能已成为常态。随着技术迭代不断加速,新的AI大模型如雨后春笋般涌现,纷纷宣称自己“比肩GPT-4”。

近日,AI公司深度求索(DeepSeek)正式发布了其开源模型DeepSeek-Coder-V2。据DeepSeek透露,该模型在代码与数学领域均展现出强大的性能,不仅在多个国际榜单上位居前列,更在中英通用能力上位列国内第一梯队。DeepSeek-Coder-V2沿用了前代模型的创新架构,拥有高达2360亿的总参数,但处理每个token时仅需激活210亿参数,既节省内存又提高计算效率。

与此同时,DeepSeek-Coder-V2支持高达32K的上下文长度,并延续了此前实惠的定价策略,为用户提供高性价比的服务。DeepSeek的这一举措也推动了国内大模型市场的价格竞争,引发了行业内外的广泛关注。

为了验证DeepSeek-Coder-V2的性能,DeepSeek公布了多项评测结果。在HumanEval评测集上,该模型在代码生成能力方面得分高达90.2,仅次于GPT-4o的91.0分。而在数学算数领域,DeepSeek-Coder-V2在GSM8K评测基准上获得了94.9的高分,超越了众多开闭源模型。

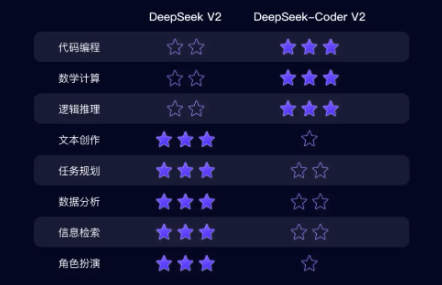

然而,在通用能力的评测中,如MMLU评测集所示,DeepSeek-Coder-V2的得分为79.2,与GPT-4仍有一定差距。DeepSeek对此表示,DeepSeek-Coder-V2与上一代模型各有擅长,“DeepSeek-V2擅长文科,而DeepSeek-Coder-V2则更擅长理科”。最新发布的大模型在代码编程、数学计算和逻辑推理方面表现突出,而上一代模型则在文本创作和任务规划等方面具有优势。

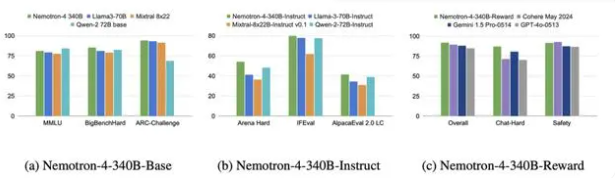

在AI大模型领域,另一家巨头英伟达也不甘示弱。当地时间6月14日,英伟达宣布开源了其Nemotron-4 340B(3400亿参数)系列模型。这一系列模型包括基础模型Base、指令对齐模型Instruct和奖励模型Reward,在多个评估基准测试中均取得了优异成绩。

Nemotron-4 340B系列模型在ARC-c、Winogrande等评估大语言模型常识推理能力的基准测试中获得了高分,表现优于其他开源模型。特别是Reward模型,在RewardBench基准测试中获得了92.0的最高分数,远超GPT-4o的84.7分。英伟达表示,这三类模型形成了一个完整的训练管道,能够生成高质量的合成数据,用于大语言模型的训练中。

随着AI大模型竞赛的升温,英伟达成为了此轮AI浪潮的最大受益者之一。当地时间6月17日,英伟达市值一度赶超苹果,距离全球市值排名第一的微软仅差100亿美元。英伟达的成功证明了其在大模型领域的深厚积累和强大实力。

川公网安备 123456789号

川公网安备 123456789号