GPT-4o瑟瑟发抖!开源模型Llama 3.1泄密,附下载链接

Llama 3.1 终于现身了,不过出处却不是 Meta 官方。

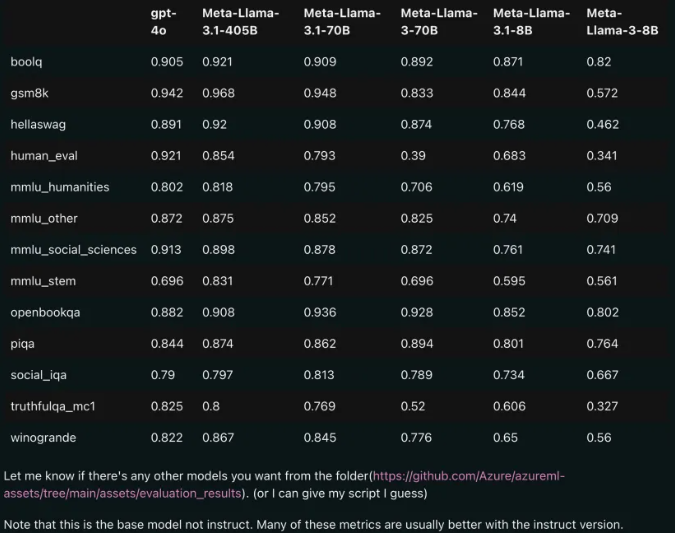

今日,Reddit 上新版 Llama 大模型泄露的消息遭到了疯传,除了基础模型,还包括 8B、70B 和最大参数的 405B 的基准测试结果。

就连磁力链接都流出来了,试着下载一下大约有763.84G。本来huggingface上也有的,后来库被删除了。

磁力地址:

Magnet: magnet:?xt=urn:btih:c0e342ae5677582f92c52d8019cc32e1f86f1d83&dn=miqu-2&tr=udp%3A%2F%https://2Ftracker.openbittorrent.com%3A8

下载速度也还可以,每秒14M左右,看来确实是有不少人在下这个模型。

但这个模型一般的GPU肯定是跑不起来,如此大的参数在部署方面个人开发者也负担不起(如果你有一些H100也没问题),估计是给企业、政务公共部门用的。

据了解,Meta Llama 3.1 多语言大型语言模型 (LLM) 集合是一组经过预训练和指令微调的生成模型,大小分别为 8B、70B 和 405B(文本输入 / 文本输出)。Llama 3.1 指令微调的纯文本模型(8B、70B、405B)针对多语言对话用例进行了优化,在常见的行业基准上优于许多可用的开源和闭源聊天模型。

模型架构:Llama 3.1 是优化了的 Transformer 架构自回归语言模型。微调后的版本使用 SFT 和 RLHF 来对齐可用性与安全偏好。

支持语言:英语、德语、法语、意大利语、葡萄牙语、印地语、西班牙语和泰语。

从模型卡信息可以推断,Llama 3.1 系列模型的上下文长度为 128k。所有模型版本都使用分组查询注意力(GQA)来提高推理可扩展性。

而通过Llama 3.1 各版本与 OpenAI GPT-4o、Llama 3 8B/70B 的比较结果。可以看到,即使是 70B 的版本,也在多项基准上超过了 GPT-4o。

显然,3.1 版本的 8B 和 70B 模型是由 405B 蒸馏得来的,因此相比上一代有着明显的性能提升。

有网友表示,这是首次开源模型超越了 GPT4o 和 Claude Sonnet 3.5 等闭源模型,在多个 benchmark 上达到 SOTA。

同时也有网友泼冷水。相比OpenAI最新的GPT-4o mini版本,Llama3.1-70B推理成本提升了3倍,但编码的性能却要差很多。

无论如何,作为一项新技术,Llama3.1备受争议也在情理之中,但它的出现对于全球多数国家来说都是一个天大的福利。因为这是Meta的Llama3系列的顶级模型并且是全部开放权重,也就是说人人都能用上免费的AI模型。

川公网安备 123456789号

川公网安备 123456789号