阿里巴巴震撼发布Qwen2-Math,数学AI新纪元来临

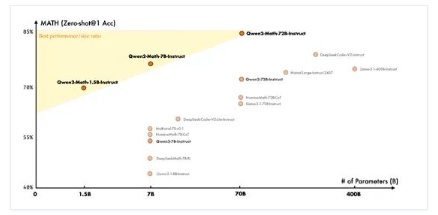

阿里巴巴近日正式向全球开源了其最新的数学计算模型——Qwen2-Math,该模型分为基础版与指令微调版两大系列,覆盖了1.5B、7B及顶尖的72B参数规模,为数学领域的人工智能应用树立了新的标杆。

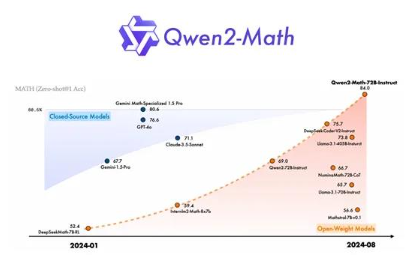

据阿里巴巴公布的权威测试数据,Qwen2-Math-72B指令微调版在多项主流数学基准测试中,其表现力压GPT-4o、Cloude-3.5-Sonnet、Gemini-1.5Pro等一众顶尖闭源模型,甚至连Meta的开源巨擘Llama-3.1-405B也未能幸免,被其远远甩在身后。这一成就无疑宣告了Qwen2-Math-72B在全球数学推理大模型领域的霸主地位。

更令人瞩目的是,Qwen2-Math-72B正跃跃欲试,准备向近期在国际数学奥林匹克竞赛中摘得银牌、仅以毫厘之差错失金牌的双混合模型AlphaProof与AlphaGeometry2发起挑战。尽管这两个模型尚处科研前沿,但Qwen2-Math的雄心壮志已显露无遗。

广大开发者及研究人员现可通过以下链接轻松获取Qwen2-Math的宝贵资源:

Hugging Face Hub: https://huggingface.co/Qwen

GitHub仓库: https://github.com/QwenLM/Qwen2-Math?tab=readme-ov-file

基础模型:扎实根基,卓越起步

Qwen2-Math的基础模型构建于Qwen2系列的1.5B、7B及72B模型之上,经过精心挑选的高质量数学专用语料库预训练,该语料库涵盖了广泛的数学网络资源、书籍、代码、考试题目及Qwen-2模型生成的专属数据,确保了模型对数学知识的全面掌握。

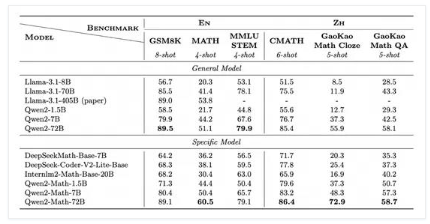

在GSM8K、Math、MMLU-STEM等国际数学基准测试,以及CMATH、GaoKao Math Cloze、GaoKao Math QA等中国数学基准测试中,Qwen2-Math基础模型均展现出了远超Llama-3.1全系列的卓越性能,通过Few-shot CoT方式验证了其强大的泛化能力。

为进一步提升模型性能,Qwen2-Math-72B指令微调版采用了创新的训练策略,结合密集的奖励信号与二元信号,通过拒绝采样方法构建SFT数据集,并运用GRPO强化学习算法进行迭代优化。这一系列精心设计的训练流程,使得模型在解答复杂数学问题时的准确性与效率均得到了显著提升。

在包括OlympiadBench、CollegeMath、高考(GaoKao)、AIME2024、AMC2023等在内的多样化数学测试中,Qwen2-Math-72B指令微调版均展现出了令人惊叹的推理能力,甚至能够解答部分IMO竞赛级别的难题,其表现全面超越了现有的开闭源模型。

为确保测试结果的公正性与准确性,阿里巴巴在预训练与微调阶段均对数据集进行了严格的去污染处理,特别是剔除了与知名基准测试集重叠的正例污染样本。这一举措不仅保障了模型的纯净性,也为后续的公平评测奠定了坚实基础。

目前,Qwen2-Math模型虽以英文为主,但阿里巴巴已明确表示将迅速推出中英双语版本,以满足全球范围内不同用户的需求。这一举措无疑将进一步拓宽Qwen2-Math的应用场景,为全球的数学教育与科研领域带来更加智能化的解决方案。

川公网安备 123456789号

川公网安备 123456789号