七步“调教”大模型,让AI比你更懂你

近年来,自然语言处理(NLP)领域的发展势头迅猛,这主要归功于OpenAI的GPT系列等大规模语言模型(LLM)的崛起。这些模型以其卓越的性能,彻底改变了我们处理自然语言任务的方式,不仅在机器翻译、情感分析,还在自动文本生成等领域取得了显著的突破。随着这些技术的成熟,越来越多的AI初创团队和产品开始涌现,为自然语言处理领域注入了新的活力。

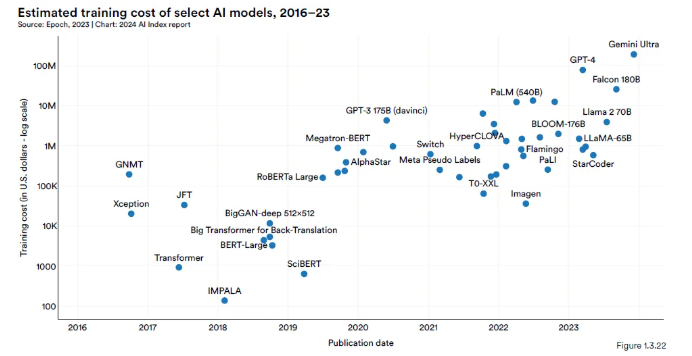

然而,值得注意的是,尽管这些大模型在性能上表现出色,但其高昂的训练成本也不容忽视。随着时间的推移,模型的规模不断扩大,训练成本也呈现指数级增长。例如,从2017年的数百美元,到2019年的数十万美元,再到如今的数千万美元,甚至更高。这种成本增长已经远远超出了大多数普通公司和团队的承受能力。

因此,对于大多数AI初创团队来说,一个更为经济实惠且可行的选择是通过对预训练模型进行微调,使其更加适用于特定的应用或领域。本文将详细介绍大模型微调的七个关键步骤,帮助读者对这一过程有一个直观的认识。

第1步:明确具体目标

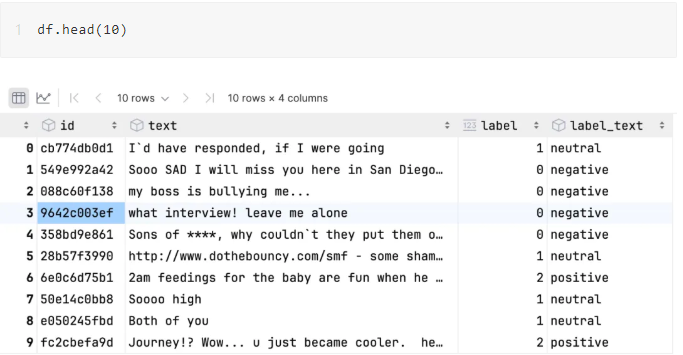

在进行模型微调之前,首先要明确我们的具体目标。例如,如果我们希望训练一个能够推断用户输入文本情感的语言模型,那么我们的目标就是使模型能够准确识别文本中的情感倾向,如中性、正面或负面。第2步:选择预训练模型与准备数据集

第2步:选择一个预训练模型,并准备好微调的数据集

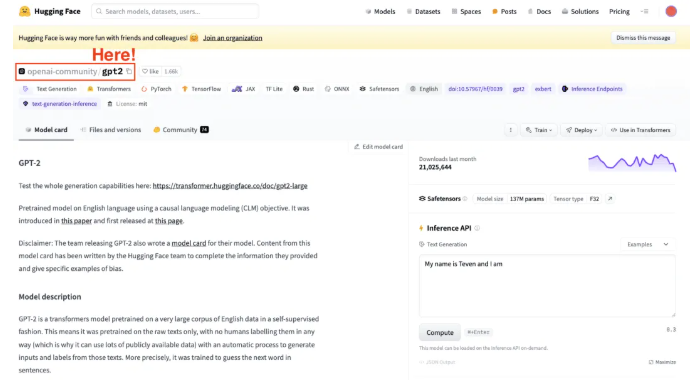

在明确了目标之后,我们需要选择一个合适的预训练模型,并准备好用于微调的数据集。目前市面上有许多开源的预训练模型可供选择,我们需要根据模型的特点和我们的需求来做出选择。同时,为了进行微调,我们还需要准备一个标注好的数据集,用于指导模型的学习过程。

第3步:加载微调数据集

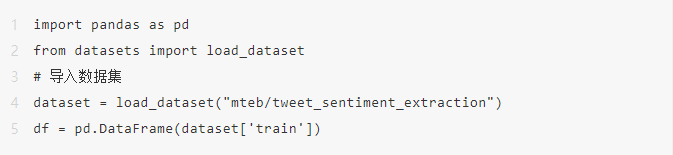

在选择了预训练模型和准备好了数据集之后,我们需要将数据集加载到我们的计算环境中。这通常可以通过调用相关的API或库来实现。例如,我们可以使用Hugging Face的datasets库来加载开源的数据集,并将其转换为适合模型训练的格式。

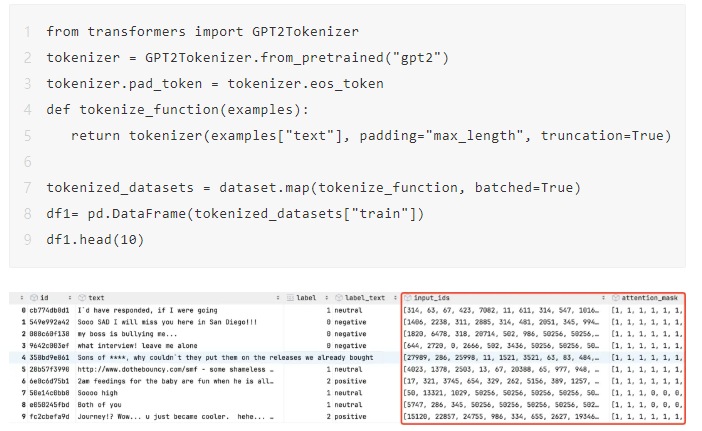

第4步:加载分词器

由于大型语言模型处理的是token而不是单词,因此我们需要一个分词器来将文本数据转换为模型可以理解的格式。分词器的选择应该与预训练模型相匹配,以确保数据的正确性和一致性。在加载了分词器之后,我们可以使用它将文本数据转换为token序列,并准备好用于训练的数据。

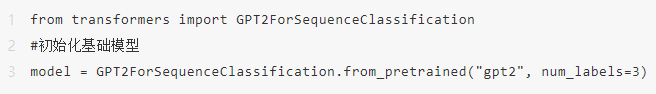

第5步:初始化基础模型

接下来,我们需要初始化一个基础模型,用于后续的微调过程。这个基础模型通常是一个已经在大规模数据集上预训练过的模型,如GPT2等。通过调用相关的API或库,我们可以加载这个模型,并对其进行必要的配置和初始化。

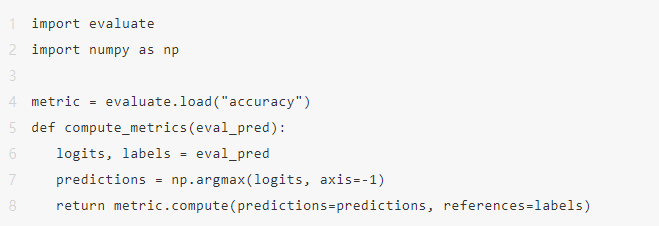

第6步:定义评估函数

在开始训练之前,我们需要定义一个评估函数来监控模型的训练过程,并评估其性能。这个评估函数应该能够计算模型在验证集或测试集上的性能指标,如准确率、召回率、F1值等。通过不断监控这些指标的变化,我们可以了解模型的训练情况,并及时调整训练策略。

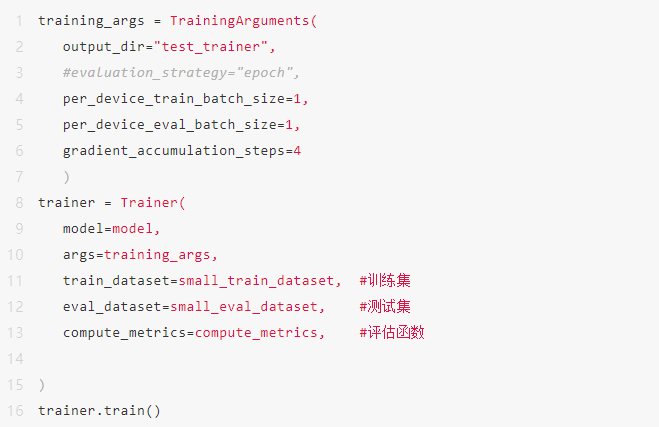

第7步:开始训练与调优

在完成了上述准备工作之后,我们就可以开始模型的训练过程了。在训练过程中,我们需要根据评估函数的反馈来不断调整模型的参数和训练策略,以优化模型的性能。此外,我们还可以使用一些先进的训练技巧和方法来加速训练过程和提高模型的性能。例如,我们可以使用分布式训练来加快训练速度,或者使用正则化技术来防止过拟合等。

通过以上七个步骤的介绍,相信读者已经对大规模语言模型的微调过程有了一个直观的认识。在实际应用中,我们还需要根据具体的需求和场景来选择合适的模型和策略,并进行不断的尝试和优化。只有这样,我们才能充分发挥出这些强大模型的优势,为自然语言处理领域的发展做出更大的贡献。

川公网安备 123456789号

川公网安备 123456789号