必备知识!这些AI专业术语,你很有必要了解

1、大模型(Large Model)

通常指在深度学习领域中具有大量参数的模型。这类模型因其巨大的规模而得名,凭借数以亿计的参数规模,能够捕捉和解析极为复杂的模式和规律。

2、大语言模型(Large Language Model, LLM)

大模型的一个子集,专指用于处理自然语言任务(如对话)的模型。LLM通过大量的文本数据训练而成,具备理解、生成和处理自然语言的能力,其中,ChatGPT作为GPT-3.5系列的杰出代表,以其卓越的对话交互能力,展现了LLM的无限潜力。

3、Prompt

提示词,是我们在与大模型交互时给出的关键性引导语句,作为与大模型沟通的桥梁,它的作用在于指导模型执行特定任务。它的重要性不言而喻,是实现人机高效交互的关键。

4、AGI

AGI(Artificial General Intelligence)即“通用人工智能”,代表了人工智能发展的终极目标,它追求的是机器能够像人类一样全面、灵活地处理各种认知任务,为我们描绘了一个智能机器人的未来世界。典型例子就是科幻电影中的智能机器人。

5、GPT

GPT(Generative Pre-trained Transformer)是一种由OpenAI开发的先进的人工智能模型。GPT与LLM的区别在于GPT是一种大型语言模型架构,属于比较具体的概念,而LLM是比较通用的概念,可以理解为GPT是LLM的一种。

6、ChatGPT

ChatGPT 是 GPT-3.5 系列模型的变体,专门为对话交互场景进行了微调优化。

与基础的 GPT 模型相比,ChatGPT 更注重对话理解和生成,它通过引入额外的训练策略和上下文记忆机制来提高连续对话的连贯性和逻辑性,使其能够更好地模拟人类般的聊天交互体验

7、Transformer

一种神经网络架构,在自然语言处理中非常流行和成功。Transformer的核心是它的注意力机制,这个机制使得模型能够聚焦于输入文本的重要部分,类似于人类在阅读或听取信息时会关注某些关键词或短语。通过Token化处理,模型能够更好地理解和处理文本信息。

举个例子,当你向Transformer描述一个场景,比如“孩子们在公园玩耍”,它能够理解“孩子们”是主要的角色,而“公园”是他们玩耍的地点。当你接着说“突然,一只狗跑了过来”,Transformer能够迅速地将“一只狗”加入到当前的上下文中,并预测接下来可能发生的事情。

8、模型参数

模型的参数是模型的调整点,它们决定了模型如何从输入数据中学习并做出预测。大模型通常拥有大量的参数,参数的数量通常与模型的复杂性和容量成正比,意味着更多的参数可能带来更强的学习能力。

9、Token

大模型中的Token是指在自然语言处理(NLP)领域中,模型处理文本时的基本单元。Token可以是单个词汇、子词(subword)、字符、标点符号或者是任何具有意义的文本片段。

在模型输入阶段,原始文本首先经过分词或Token化处理,将其分解成一系列离散的Token,目前的大模型一般也是按Token进行收费

10、模型泛化

模型泛化是指在机器学习尤其是深度学习领域中,大型神经网络模型经过训练后,不仅能在训练数据上表现出色,还能在之前未见过的新数据上保持良好性能的能力。

模型泛化可以引申出两个概念:欠拟合和过拟合。欠拟合简单来说就是在训练数据表现不好,然后在未见过的新数据同样表现不好;而过拟合简单来说就是在训练数据表现不错,但是在未见过的新数据表现欠佳。

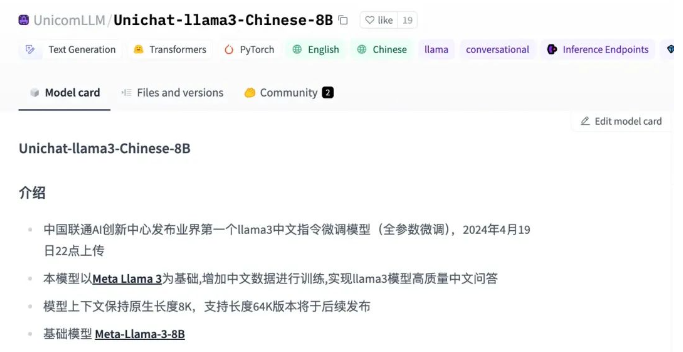

11、指令微调

针对已经存在的预训练模型,给出额外的指令或者标准数据集来提升模型的性能。典型例子就是新开源的Llama3大模型只用了 5% 左右的非英语训练集,这就导致了它在中文的表现上不是很优秀,所以一般都会用一些中文语料对它进行一个微调,提升它在中文回答上的表现。

12、RAG

检索增强生成,简单来说RAG技术就是通过将传统的文本生成过程与实时的信息检索相结合,使得模型能够在生成响应时参考最新的、相关的外部信息。这种技术的核心思想是,通过检索补充模型的预训练知识,提高生成文本的准确性和相关性,从而在问答、内容创作、摘要生成等任务中取得更好的效果。

13、幻觉问题

简单来说就是大模型在“胡说八道”,模型生成的内容与现实世界事实不一致,可以通过上述的RAG技术进行优化

14、量化

大模型的量化是指将深度学习模型中的参数(如权重和偏置)从浮点数转换为低精度的表示形式,例如整数或二值化表示。

比如一个7B的模型用32位浮点数存储,那么使用该模型需要 28 GB 的内存容量,但是通过4位量化,使用该模型仅需要3.5GB,所以量化可以显著减少模型的内存占用,你也可以简单理解为将模型压缩!

15、AI Agent

在大模型语境下,Agent可以理解为某种能自主理解、规划决策、执行复杂任务的智能体。

类似人类“做事情”的过程,Agent的核心功能可以归纳为三个步骤的循环:感知(Perception)、规划(Planning)和行动(Action)

比较典型的例子就是我们之前讲过的Devin机器人,可以自己发现Bug(感知),并且知道去浏览器查找解决办法(规划),最终解决该Bug(行动)

16、多模态

多模态可以通过一个例子说明,想象一下,我们在于他人交流时不仅通过语言(说话或文字),还会通过表情、手势、图像、声音等多种方式进行互动,这就是现实生活中的“多模态”沟通。

在技术层面,多模态则是指计算机系统能够同时理解和处理多种不同形式的数据输入,比如一个大模型能够同时理解和处理不同形式的数据输入。

17、LoRA

LoRA全称"Low-Rank Adaptation"(低秩适应),这是微软的研究人员为了解决大语言模型微调而开发的一项技术,目的是在保持大模型高性能的同时,降低微调过程中的计算资源需求和内存消耗。

LoRA的工作机制是在大模型(如GPT系列或LLM等)的Transformer架构中引入低秩分解矩阵,而不是对整个模型的所有参数进行微调(因为直接对GPT-3做微调,成本太高太麻烦)

18、LangChain

LangChain是一个用于构建和集成大型语言模型(LLM)到应用程序中的开源开发框架。它致力于简化使用LLM进行应用程序开发的过程,通过提供一系列工具和组件来促进LLM与其他功能模块的有效协作,从而构建出具有上下文感知、推理能力以及与外部工具交互能力的高级应用程序。

川公网安备 123456789号

川公网安备 123456789号