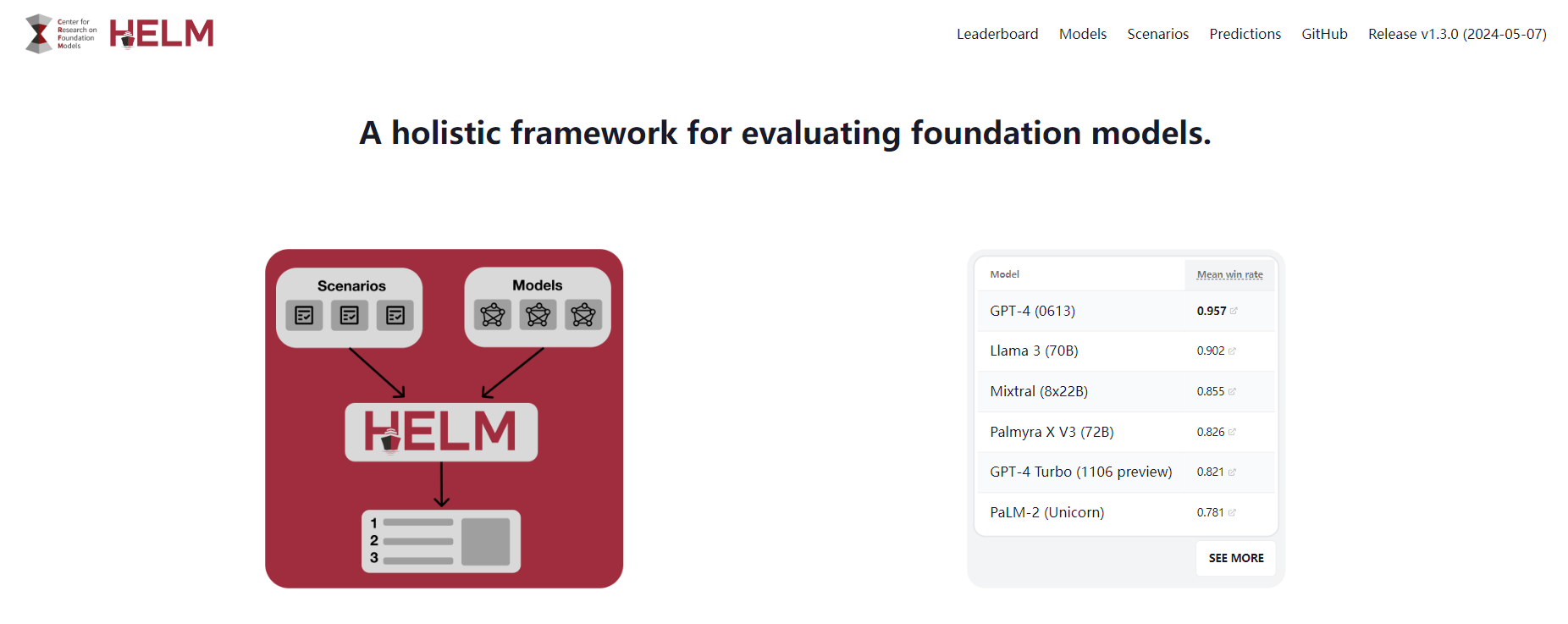

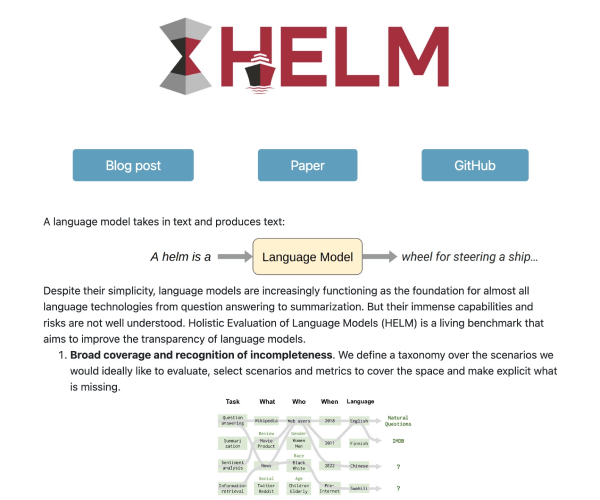

HELM全称Holistic Evaluation of Language Models,意为语言模型整体评估。这一评测体系由斯坦福大学的研究人员精心设计,旨在全面评估语言模型在多个方面的性能。HELM评测方法主要包括场景、适配、指标三个模块,每次评测的运行都需要指定一个场景,一个适配模型的提示,以及一个或多个指标。这种设计使得HELM能够根据不同的应用场景和需求,灵活调整评测参数,从而更加准确地评估语言模型的性能。

场景模块:HELM支持多种应用场景的评测,包括问答、信息检索、摘要、文本分类等。这种设计使得HELM能够更加贴近实际应用场景,评估语言模型在不同场景下的性能。

适配模块:在评测过程中,用户需要根据所选择的场景,为模型提供适当的提示。这些提示可以帮助模型更好地理解任务要求,从而更加准确地完成任务。这种适配模块的设计使得HELM更加灵活,能够适应不同模型和任务的需求。

指标模块:HELM的评测指标涵盖了准确率、不确定性/校准、鲁棒性、公平性、偏差、毒性、推断效率等七个方面。这些指标不仅关注模型的准确性,还关注模型的可靠性、公平性和社会责任。这种全面的评测指标设计使得HELM能够更加全面、客观地评估语言模型的性能。

@版权声明:部分内容从网络收集整理,如有侵权,请联系删除!

川公网安备 123456789号

川公网安备 123456789号