截胡OpenAI,微软推出iPhone能跑的ChatGPT级模型

近日,微软迅速出手,截胡了刚发布不久的Llama 3,引发了业界的广泛关注。同时,微软发布的新款Phi-3系列小模型技术报告也在AI圈内引起了热议。

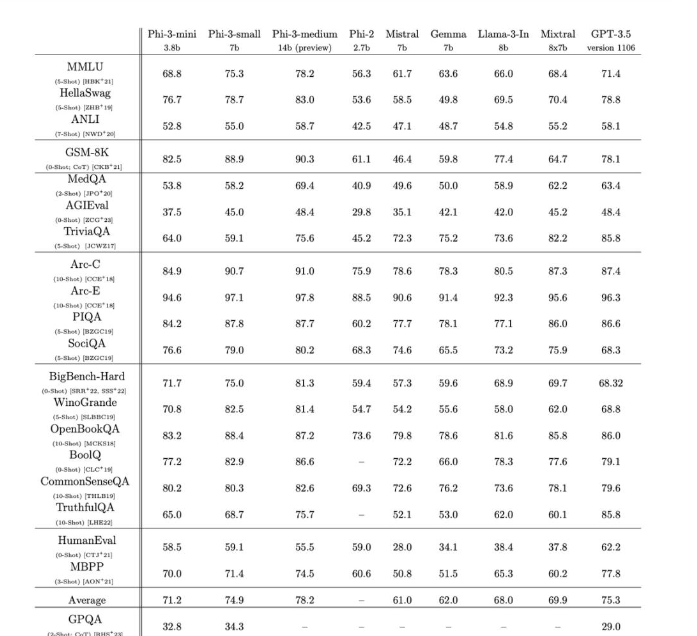

在这份技术报告中,微软展示了其Phi-3系列小模型的卓越性能。其中,仅拥有3.8B参数的Phi-3-mini在多项基准测试中竟然超越了拥有8B参数的Llama 3,这一成绩无疑令人瞩目。而且,为了方便开源社区的使用,微软还特意将其设计成了与Llama系列兼容的结构,这一举措无疑增加了其吸引力。

更值得一提的是,微软这次打出了“手机就能直接跑的小模型”的旗号。经过4bit量化后的phi-3-mini在iPhone 14 pro和iPhone 15使用的苹果A16芯片上,竟然能够达到每秒12 token的运行速度。这意味着,现在手机上能本地运行的最佳开源模型,已经具备了ChatGPT级别的性能。

在技术报告中,微软还玩了一把“花活”,让phi-3-mini自己解释为什么构建小到手机能跑的模型很令人惊叹。这种自我解释的能力,无疑展示了Phi-3系列小模型的智能水平。

除了Phi-3-mini之外,微软还发布了Phi-3-small和Phi-3-medium两款小模型。其中,Phi-3-small拥有7B参数,为了支持多语言功能,它换用了tiktoken分词器,并额外增加了10%的多语种数据。而Phi-3-medium则拥有14B参数,它在更多数据上进行训练,多数测试中已经超越了GPT-3.5和Mixtral 8x7b MoE。

那么,Phi-3系列小模型到底有什么独特之处呢?根据技术报告中的披露,其核心秘诀就在于数据。微软团队发现,单纯堆砌参数量并不是提升模型性能的唯一路径,而精心设计训练数据,尤其是利用大语言模型本身去生成合成数据,配合严格过滤的高质量数据,反而能让中小模型的能力大幅跃升。

在Phi-3系列的训练中,微软团队更是下了血本。他们投喂了多达3.3万亿token的训练数据(medium中杯是4.8万亿),大幅强化了数据的“教育水平”过滤,使用了更多样化的合成数据,涵盖了逻辑推理、知识问答等多种技能。此外,他们还采用了独特的指令微调和RLHF训练,大幅提升了模型的对话能力和安全性。

举个例子,微软团队在训练过程中,删除了某些可能加强知识的数据,如足球比赛结果等,而更多地保留了能提高模型推理能力的数据。这样一来,相比Llama-2系列,Phi-3系列就能用更小的参数获得更高的MMLU测试分数。

当然,小模型毕竟是小模型,也存在一些不可避免的弱点。微软透露,由于模型本身的参数有限,无法存储太多的事实和知识。为了缓解这一问题,他们采取了联网接入搜索引擎增强的方法。

总的来说,微软研究院团队在小模型+数据工程这条路上走得非常坚定。未来,他们还将继续增强小模型的多语言能力、安全性等指标,以期在AI领域取得更大的突破。

对于开源小模型超过ChatGPT这一事实,不少网友纷纷表示,现在压力已经给到了OpenAI这边,他们需要尽快推出GPT-3.5的继任者,以应对微软等竞争对手的挑战。

川公网安备 123456789号

川公网安备 123456789号