Epoch 最新AI研判:机器学习正在突破摩尔定律

近日,备受瞩目的Epoch AI机构发布了关于机器学习未来趋势的最新研究报告。该报告深入探讨了计算、数据、硬件、算法和成本等多个维度对人工智能模型发展的影响,为业界提供了宝贵的洞察和预测。

Epoch AI作为业内领先的研究机构,始终致力于探索影响人工智能进步和治理的核心趋势。此次报告联合了包括StandfordHAI在内的多家权威学术机构,并部分成果已在ICML等顶级期刊和会议上发表,其权威性不言而喻。

一、计算力飞跃:前沿AI模型训练计算量持续飙升

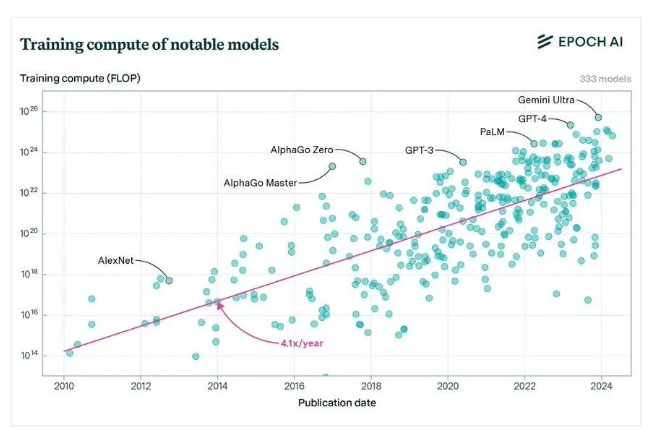

Epoch AI对超过300个机器学习系统的细致分析显示,从2010年到2024年5月,用于训练近期AI模型的计算量每年增长高达4至5倍。这一增长速度不仅涵盖了前沿模型、大型语言模型,还涵盖了各大领先公司的模型。

具体来看,自2010年以来,著名机器学习模型的训练计算量以每年4.1倍的速度激增。而在1956年至2010年间,这一增长速度仅为每年1.5倍。对排名前10的前沿模型进行统计观测后发现,在2018年前,这些模型的计算量增长速度甚至快于总体趋势,高达每年6.7倍,这可能与各大实验室积极投身AI竞赛有关。然而,2018年之后,这一增长速度放缓至与总体趋势相当,即每年4.2倍。

在语言模型领域,作为当今最重要的模型之一,前沿大型语言模型(LLM)在过去十年中经历了快速的计算增长。以GPT-3为例,自2020年以来,其计算增长已放缓至每年5倍。同时,OpenAI、Google DeepMind和Meta AI等领先的人工智能实验室也一直在以与总体趋势相对一致的速度扩展其模型,平均每年增长5至7倍。

这一惊人的增长速度不仅带来了工程和科学上的巨大挑战,还意味着训练过程将越来越依赖庞大的GPU集群。例如,Gemini Ultra可能是目前计算最密集的模型之一,其最后一次训练运行的总计算量估计高达5e25FLOP。

二、数据挑战:2028年或面临文本数据耗尽危机

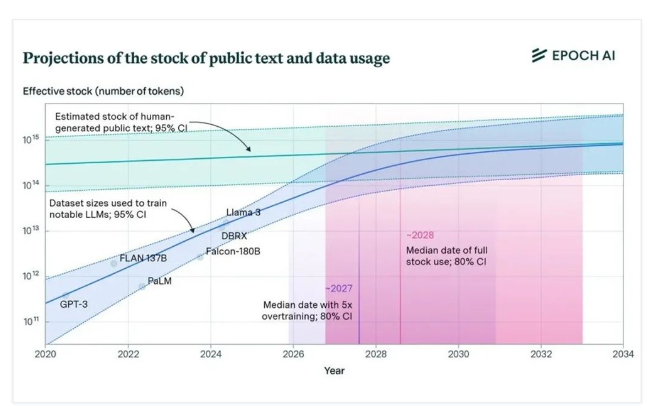

在数据趋势方面,Epoch AI的报告提出了一个引人关注的观点:到2028年,人类可用于训练的文本数据可能会被消耗殆尽。

为了验证这一观点,Epoch AI采用了常用于搜索引擎研究的方法来估算索引网站的大小。通过对网络语料库(如Common Crawl)进行词频分析,并结合在Google搜索中不同单词的词频和页面数量,他们计算出网络上大约有500万亿个Token。然而,在排除不适合大型语言模型训练的数据集后,实际可用于训练的文本数量将大幅下降至100万亿个Token。

那么,何时会耗尽这些文本数据呢?Epoch AI预计,在大约100T Token上训练一个4个Epochs的模型将消耗约5e28FLOP的计算资源,这比GPT-4高出3个数量级(OOMs)。根据模型算法的增长速度,预计在2028年左右将达到这一临界点。如果过度训练,这一时间甚至可能提前到来。

目前,Llama370B模型以其15万亿个Token的训练数据成为公开确认的拥有最大训练数据集的模型。然而,除了已编入索引的网络数据外,还有大量的“深层”网络和私人数据尚未被充分利用。Epoch AI估算,在Facebook、Instagram和WhatsApp等社交媒体和消息应用中存在约3000T Token的潜在数据资源。

为了在2028年后继续维持当前的进展速度,开发或改进替代数据源(如合成数据)显得尤为重要。尽管面临诸多挑战,但这些挑战也为机器学习领域带来了更多的机遇和可能性。

三. 硬件演进之路:ML硬件性能飙升

随着机器学习领域的蓬勃发展,ML硬件的性能也在持续攀升。Epoch AI针对2010年至2023年间广泛使用的47款机器学习加速器(GPU和其他AI芯片)进行了深入研究。结果显示,这些ML硬件加速器中的FLOP/s性能每2.3年便实现翻倍,而内存容量和带宽则每4年翻一番。

在大型分布式ML训练场景中,硬件集群的整体性能受到多方面因素的影响,包括GPU的计算性能、内存容量、内存带宽以及互连能力等。尤其是内存和互连带宽,已成为利用这些大型集群峰值计算性能的瓶颈。

在性价比方面,ML GPU的计算性价比(FLOP/$)每2.1年翻一番,而通用GPU则每2.5年翻一番。从能效角度看,ML GPU的能源效率(FLOP/s/瓦特)每3.0年翻一番,通用GPU则为每2.7年翻一番。

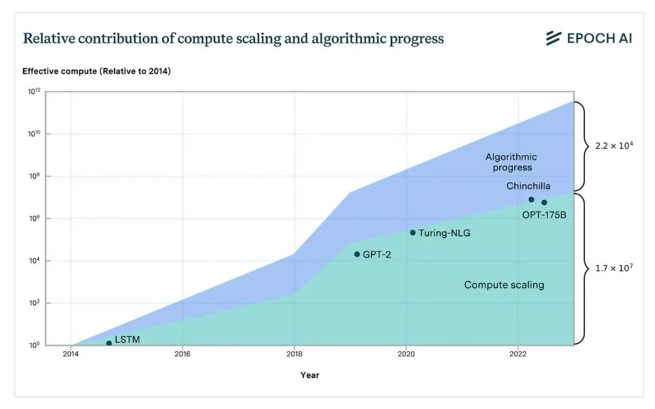

四. 算法迭代革新:语言模型性能飞跃

算法作为机器学习领域的核心驱动力之一,其进步速度令人瞩目。Epoch AI在对LLM(大型语言模型)的算法升级进行深入研究后发现,算法的进步使得模型在达到给定性能水平时所需的计算量大约每8个月便减半,这一速度在95%的置信区间内为5到14个月,再次超越了摩尔定律。

特别值得一提的是,Transformer架构的引入相当于该领域近两年的算法进展。而Chinchilla缩放定律的引入,则相当于带来了8到16个月的算法进步。

在探讨模型性能改善的原因时,Epoch AI发现计算效率的提高解释了自2014年以来语言建模性能改进的约35%,而计算规模的增加则解释了模型性能65%的改进。

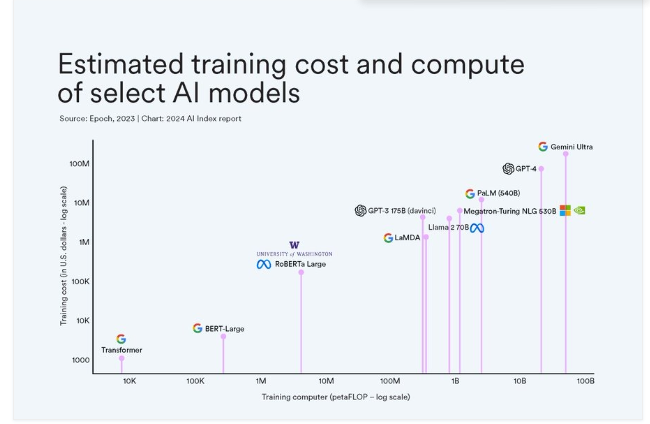

五. 成本挑战与机遇:模型训练成本飙升

随着模型复杂度的不断提升,其训练成本也在快速增长。Epoch AI对45个前沿模型进行估算后发现,自2016年以来,训练这些前沿ML模型的美元成本总体增长率为每年2.4倍。同时,用于训练这些模型的硬件购置成本每年增长2.5倍。

在过去的几年里,大型科技公司间的模型成本竞赛已经达到了新的高度。例如,开发Gemini Ultra的总摊销成本(包括硬件、电力和员工薪酬)估计高达1.3亿美元,而其硬件购置成本更是高达6.7亿美金。

按照当前的增长速度,预计到2027年,最大的模型成本将超过10亿美金。在成本拆分方面,AI加速器芯片、其他服务器组件和互连硬件的总成本占总成本的47-67%,而研发人员成本占29-49%(包括股权),能源消耗占剩余成本的2-6%。

尽管当前能源消耗在总成本中的占比相对较小,但由于模型所需的电力容量巨大(如Gemini Ultra预计需要35兆瓦),预计到2029年,人工智能超级计算机将需要千兆瓦级的电力供应。这一趋势不仅带来了挑战,也为能源管理和可持续发展提供了新的机遇。

川公网安备 123456789号

川公网安备 123456789号