科技大厂开卷小模型,苹果、英伟达、OpenAI都已入局

继GPT-4o mini、Mistral NeMo发布之后,苹果也入局了。

DCLM小模型包含两种参数规模——70亿和14亿,发布即开源。最大70亿参数超越了Mistral-7B ,性能接近Llama3、Gemma。

DCLM-7B同样采用了decoder-only的架构,使用PyTorch和OpenLM框架进行预训练。

上下文长度为2048,小于Mistral7B和Gemma29B的8k长度。

性能方面,作者直接使用评估套件LLM Foundry,测试了模型在53个基准任务上的分数。

与其他模型进行比较时,除了MMLU分数,作者还自定义了两个指标——「核心准确率」(core)和「扩展准确率」(extended)。

前者是包括HellaSwag和ARC-E在内的22个任务中心准确率的均值,后者则涵盖全部53个任务。

与虽然使用的数据不是最多,但与其他同等大小的开放数据模型(权重与数据集都开源)相比,DCLM在全部3个指标上的性能都达到了最佳。

总共4T token的DCLM-baseline数据集来自于总量240T的DCLM,DCLM-7B模型又进一步过滤出其中的2.5T用于训练。

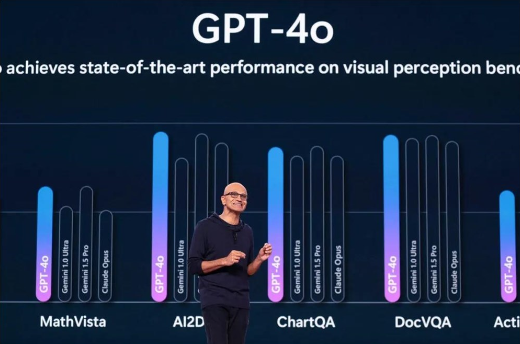

苹果的入局,也意味着科技大厂开始卷“小模型”了。这周,OpenAI突然发布GPT-4o mini,Mistral AI联手英伟达发布Mistral NeMo,HuggingFace的SmoLLM等小模型的发布,为小模型的领域再次添了一把火。

与动辄上千亿参数的大模型相比,小模型的优势是显而易见的:它们不仅计算成本更低,训练和部署也更为便捷,可以满足计算资源受限、数据安全级别较高的各类场景。因此,在大笔投入大模型训练之余,像 OpenAI、谷歌等科技巨头也在积极训练好用的小模型。

就以GPT-4为例,开发和使用超一万亿参数的成本超过了1亿美元。

而小模型,比如专在法律数据集上完成训练,可能使用不到100亿参数,成本不到1000万美元,使用更少算力响应每个查询,因此成本较低。

纳德拉曾表示,Phi⼩型模型系列规模仅为OpenAI背后免费模型1/100,而且在许多任务上的表现几乎同样出色。

随着各行业的企业继续努力将 AI 整合到他们的运营中,像 DCLM 这样的模型代表了向更高效、可部署的 AI 解决方案的转变。这是否会挑战更大、基于云的模型的主导地位还有待观察,但它无疑为 AI 在企业环境中的整合开辟了新的可能性。

川公网安备 123456789号

川公网安备 123456789号