苹果放大招!7B模型全面开源,网友:这波我站苹果

苹果公司近期强势进军开源大模型领域,其最新推出的7B模型不仅性能直逼业界领先的Llama38B,更以史无前例的开放姿态,将全部训练过程和资源一次性公开,树立了行业新标杆。

这一举动无疑是对当前AI模型开源现状的一次有力回应。此前,Nature杂志的资深编辑Elizabeth Gibney曾尖锐指出,许多所谓的开源AI模型在数据和训练方法上遮遮掩掩,严重阻碍了科学研究的深入发展。而苹果此次的开放举措,无疑为行业带来了一股清流。

NLP领域的专家及AutoAWQ的创始人更是对苹果的这一举动赞不绝口,称赞其不仅发布了一个性能卓越的模型,更重要的是,它彻底打破了信息壁垒,让预训练数据集等核心资源也得以公之于众。

网友们也纷纷加入讨论,有人调侃道:“苹果这次是来真的了!”而更多人则是对这一开源行为表示了高度认可,认为它对于推动AI技术的普及和发展具有重要意义。

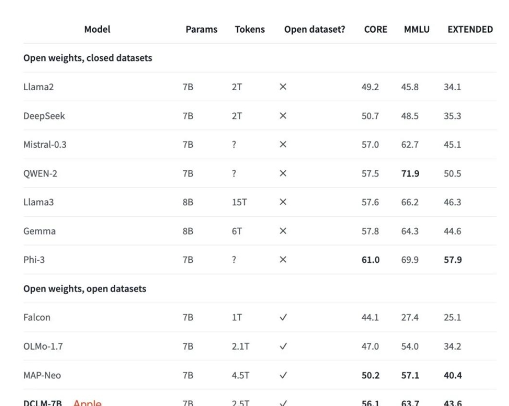

从模型的具体配置来看,苹果的7B模型在开放数据集上使用了2.5T的tokens进行训练,主要基于英文数据,拥有2048tokens的上下文窗口。其数据集涵盖了DCLM-BASELINE、StarCoder和ProofPile2等多个高质量资源,确保了模型的广泛适用性和强大性能。

在MMLU基准测试中,该模型表现出了惊人的实力,5-shot准确率高达64%,与Mistral-7B-v0.3和Llama38B等顶尖模型不相上下。同时,在53个自然语言理解任务上的平均表现也足以与Llama38B相媲美,但计算量却仅为后者的六分之一,充分展示了其高效节能的特点。

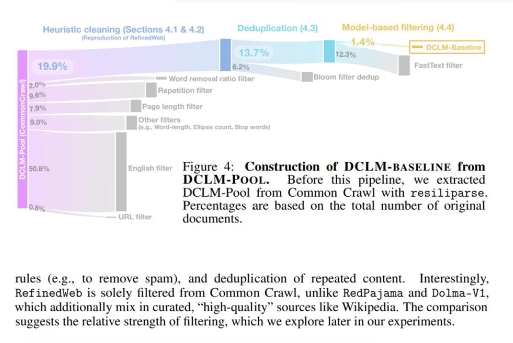

此外,苹果的研究团队还提出了一种新的语言模型数据基准——DCLM,旨在通过标准化的框架来筛选出最适合训练高性能模型的数据整理策略。基于这一基准,他们成功构建了一个高质量的数据集DCLM-BASELINE,并据此训练出了DCLM-7B模型。实验结果表明,该模型在多个基准测试中的表现均优于同等大小的模型,充分证明了其优越性和实用性。

值得一提的是,随着“小”模型逐渐成为行业新趋势,苹果此次的开源举动无疑为这一趋势注入了新的动力。从HuggingFace推出的小模型家族“SmolLM”到OpenAI发布的GPT-4o mini再到Mistral AI与英伟达联合发布的Mistral NeMo小模型,都展现出了小模型在降低成本、提升效率方面的巨大潜力。而苹果的加入无疑将这一趋势推向了新的高潮。

综上所述,苹果此次发布的开源大模型不仅在性能上达到了业界领先水平,更在开放性和透明度方面树立了新的标杆。我们有理由相信,在苹果的引领下,未来的AI模型将更加开放、透明和高效,为人类的科技进步和社会发展贡献更大的力量。

川公网安备 123456789号

川公网安备 123456789号