超越GPT-4,Octopusv2成为手机端大模型霸主

在大模型落地应用的过程中,端侧 AI 是非常重要的一个方向。

近日,斯坦福大学研究人员推出的 Octopus v2 火了,受到了开发者社区的极大关注,模型一夜下载量超 2k。

这款拥有20亿参数的Octopus v2模型,不仅可以在智能手机、汽车、个人电脑等端侧设备上流畅运行,更在准确性和响应速度上超越了GPT-4,同时将上下文长度减少了高达95%。值得一提的是,它在性能上比Llama7B + RAG方案快了36倍。这引发了众多网友的感慨:设备端AI智能体的时代真的到来了!

Octopus-V2-2B,作为一个专为Android API量身打造的开源语言模型,其目标是在Android设备上实现无缝运行,并将其实用性扩展到从系统管理到多设备编排等各种应用场景。为了克服检索增强生成(RAG)方法中对潜在函数参数的详细描述需求(有时需要多达数万个输入token),Octopus-V2-2B在训练和推理阶段引入了创新的函数token策略。这一策略不仅使模型达到了与GPT-4相当的性能水平,还大大提高了推理速度,使其特别适用于边缘计算设备。

论文:https://arxiv.org/abs/2404.01744

产品入口:https://huggingface.co/NexaAIDev/Octopus-v2

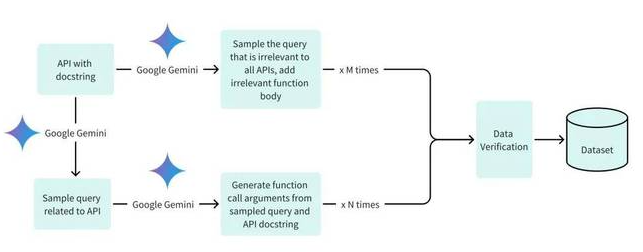

为了保障模型在训练、验证和测试阶段的数据质量,研究团队精心创建了数据集,并采用了三个关键阶段。其中,他们编写了20个Android API描述,作为训练模型的重要素材。这些描述详细描述了API的功能和参数,为模型的学习提供了丰富的上下文信息。

在模型的开发与训练方面,研究团队以Google Gemma-2B模型为框架,采用了完整模型训练和LoRA模型训练两种不同方法。在完整模型训练中,他们使用了AdamW优化器,并设置了相应的学习率和warm-up步数。而在LoRA模型训练中,他们同样采用了相同的优化器和学习率配置,并对特定模块应用了LoRA技术。无论是哪种训练方法,他们都设定了3个epoch进行训练。

此外,研究团队还提供了在单个GPU上运行Octopus-V2-2B模型的代码示例,使得开发者能够轻松地在自己的环境中进行模型推理和测试。这无疑为端侧AI的发展注入了新的活力,预示着设备端AI智能体的未来充满了无限可能。

下面是一个 Android API 描述示例:

def get_trending_news (category=None, region='US', language='en', max_results=5):

Fetches trending news articles based on category, region, and language.

Parameters:

- category (str, optional): News category to filter by, by default use None for all categories. Optional to provide.

- region (str, optional): ISO 3166-1 alpha-2 country code for region-specific news, by default, uses 'US'. Optional to provide.

- language (str, optional): ISO 639-1 language code for article language, by default uses 'en'. Optional to provide.

- max_results (int, optional): Maximum number of articles to return, by default, uses 5. Optional to provide.

Returns:

- list [str]: A list of strings, each representing an article. Each string contains the article's heading and URL.

川公网安备 123456789号

川公网安备 123456789号