又整花活!让奥黛丽赫本唱《上春山》,阿里的这个APP彻底火了

把一段音频、一张照片输入 AI 模型,就能让图中人物开口唱歌说话,让奥黛丽赫本唱《上春山》、陶俑仕女说英文 RAP、爱因斯坦说中文段子。近日,阿里的EMO模型上线了并开启线上内测通道,目前已经接入到通义千问App中。

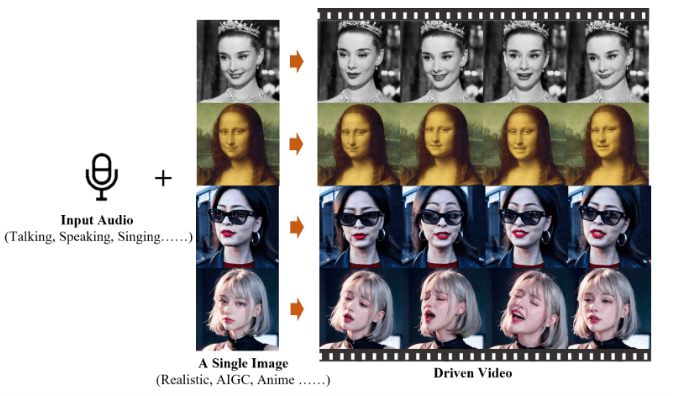

简单了解一下EMO模型的主要作用:它是一个图片转视频的AI模型,只需要提供一张照片和一段任意音频文件,EMO即可生成会说话唱歌的 AI 视频,以及实现无缝对接的动态小视频。

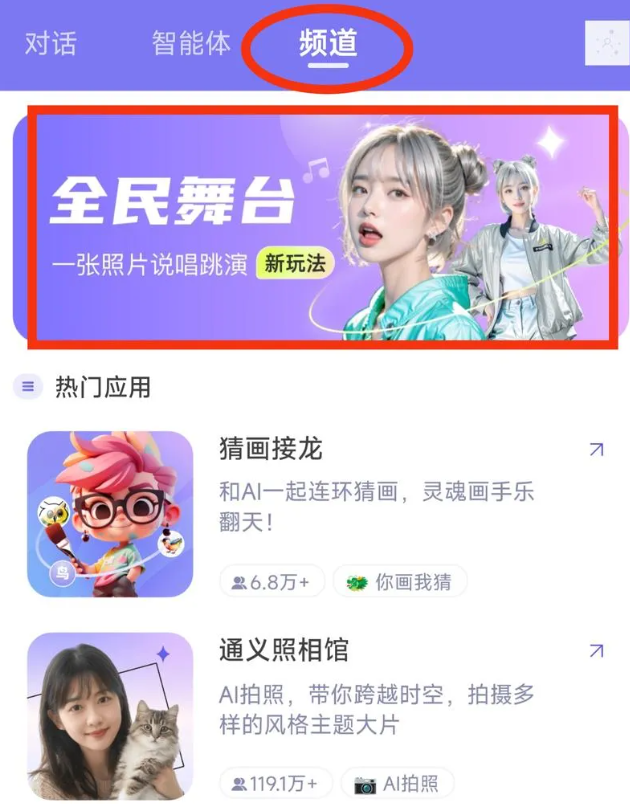

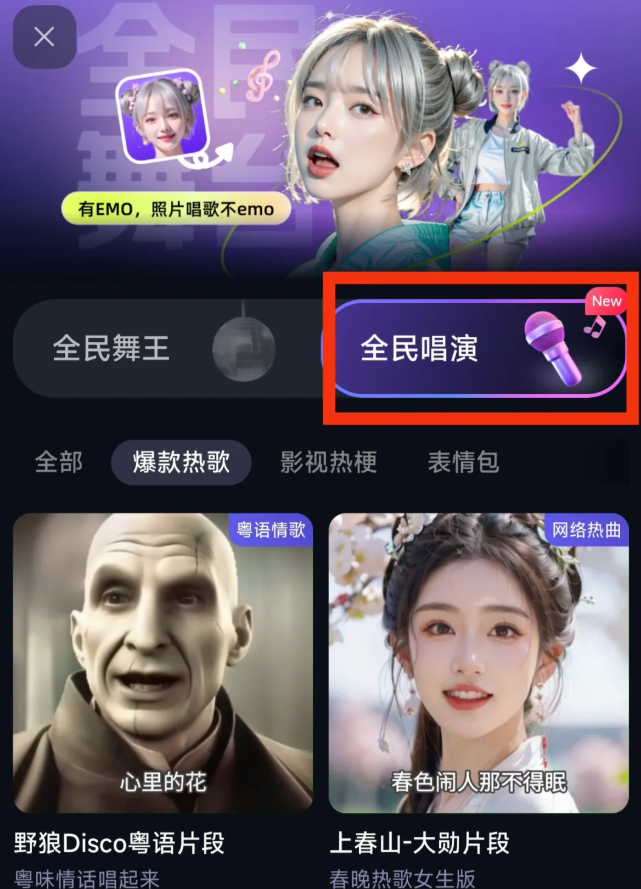

目前,通义 APP 首批上线了 80 多个 EMO 模板,包括热门歌曲《上春山》《野狼 disco》等,网络热梗 " 钵钵鸡 "" 回手掏 " 等,需要注意的是,通义 APP 暂不开放用户自定义音频,用户只能选择 APP 预置的音频来生成视频。

一、如何使用呢?

1.首先下载通义千问APP。包含EMO模型的通义千问APP的下载链接:https://humanaigc.github.io/emote-portrait-alive/

arXiv 研究论文:https://arxiv.org/abs/2402.17485

GitHub:https://github.com/HumanAIGC/EMO

2.打开通义千问后发送”emo“。即可进入”全民唱演“的功能。

接下来就按照提示,上传照片,选择模版,等待生成就好了。

不过目前不支持用户自己上传音频,只能用模板中的音频来生成。

二、EMO模型的特点

简便的操作: 用户只需提供一张照片和克隆的语音模型,即可定制自己的数字人像。

低成本: 与Heygen等需要录制长视频和高算力成本的产品相比,EMO模型提供了一种免费且高效的解决方案。

广泛的适用性: 不仅限于写实人像,3D模型和二次元漫画风格也能生成视频,满足不同用户的需求。

自然的表达: EMO模型在talking head领域首次提出weak condition(弱控制)设计,通过较弱的控制条件引导diffusion去噪过程,生成表情丰富、表现力强的人脸。

三、技术实现

EMO模型通过算法pipeline中的face locator和speed layers控制人脸生成区域与人头动作频率,保留了diffusion模型的生成创造能力。

模型在训练中学习音频特征与图像像素的对应关系,放大音频特征对相关像素的影响,确保人物表情口型与音频特征一致。

EMO在250小时的人物讲话视频上训练,不仅匹配了音频中具体发音与人像口型,还发现了音频中的语气特征与人物表情的关联性,将音频中的情绪色彩反映到人物微表情上。

实际上,通义 APP 近期爆款频出,现象级应用 " 全民舞王 " 曾在社交平台掀起 " 兵马俑跳科目三 "" 金毛跳舞 " 的热潮,全民舞王背后的模型 Animate Anyone 也出自通义实验室。近期,通义 APP 还陆续推出了超长文档解析、AI 编码助手、AI 会议助手等免费实用功能。通义大模型正在成为越来越多用户的超级 AI 助手。

EMO 是通义实验室研发的 AI 模型,其背后的肖像说话(Talking Head)技术是当前大热的 AIGC 领域。EMO 之前的 Talking Head 技术都需针对人脸、人头或者身体部分做 3D 建模,通义实验室在业界率先提出了弱控制设计,无需建模就可驱动肖像开口说话,不仅降低视频生成成本,还大幅提升了视频生成质量。EMO 学习并编码了人类表达情绪的能力,能将音频内容和人物的表情、嘴型匹配,还能把音频的语气特征和情绪色彩反映到人物微表情上。

现在,通义 APP 让所有人都可免费体验前沿模型的创造力。未来,EMO 技术有望应用于数字人、数字教育、影视制作、虚拟陪伴、电商直播等场景。

川公网安备 123456789号

川公网安备 123456789号