让AI学会打光,从此利好电商(Stable Diffusion进阶篇:Imposing Consistent Light)

在前两篇笔记中分别使用本地部署和Forge UI的方式进行IC-Light的操作,想必看过前两篇笔记的小伙伴对这个调光的操作流程和大概的原理已经理解了。

但是比起Forge UI和本地部署,大部分学习stable diffusion的小伙伴应该会更多选择ComfyUI和WebUI。目前IC-Light扩展可以添加到WebUI上,但是好像模型调用方面还有点问题,所以今天的文章还是先了解一下如何在Comfy UI使用IC-Light。

先说一下,ComfyUI时不时会出现一些节点问题我还没能解决,这几天一直在捣鼓这些,所以这篇文章我写得头昏眼花希望大家见谅。

IC-Light的下载安装

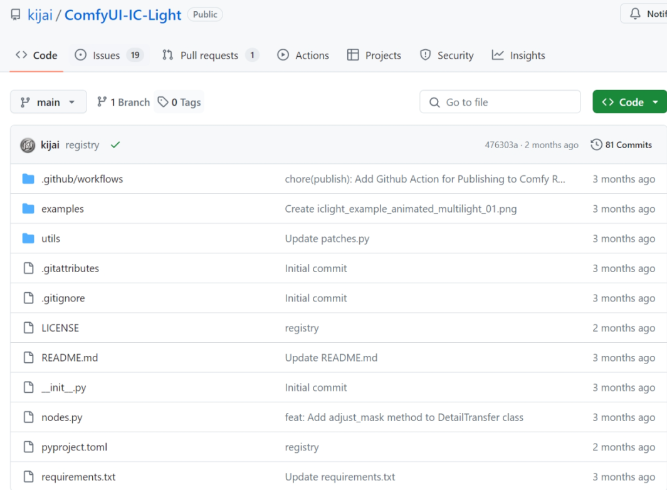

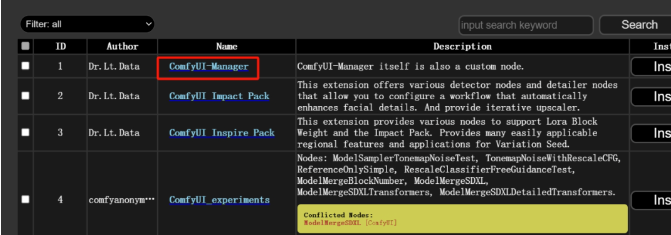

有两个不同的节点包可以在ComfyUI中安装IC-Light,一个是kijai大佬的节点包:

https://github.com/kijai/ComfyUI-IC-Light

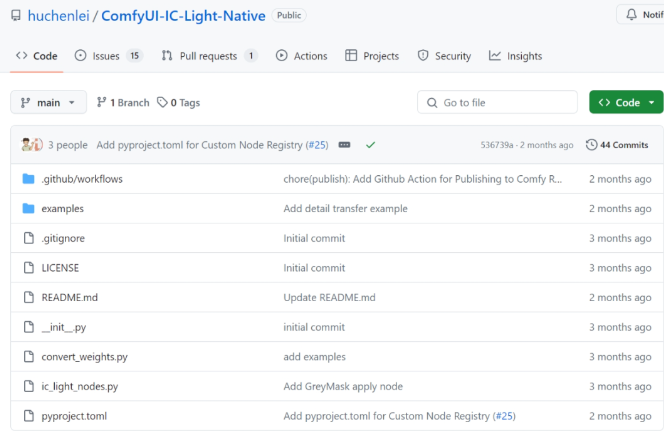

另一个是huchenlei大佬的节点包:

https://github.com/huchenlei/ComfyUI-IC-Light-Native

这两个节点都可以通过Manager安装后在自定义节点文件夹里找到示例的工作流。

关于ComfyUI的安装可以看这篇笔记:

什么!还有高手?(AI绘画:ComfyUI的基本安装和使用)

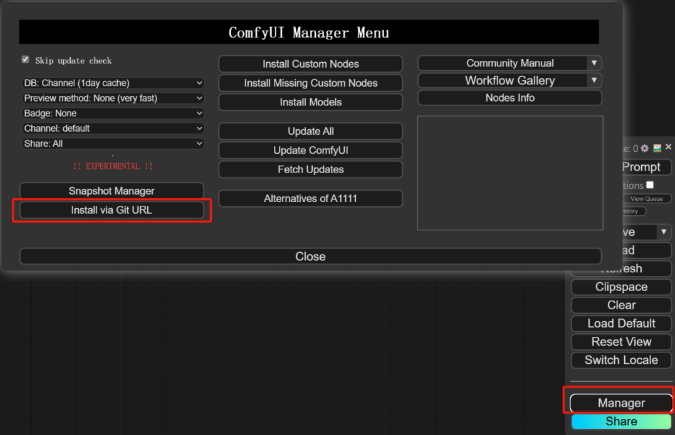

下载方式也很简单,打开ComfyUI后点击Manager,然后在网址部分输入上述的两个地址。

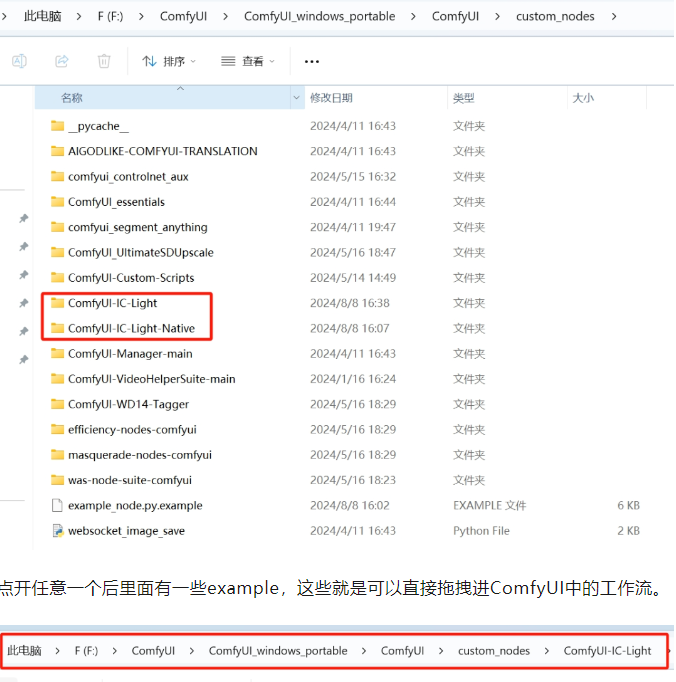

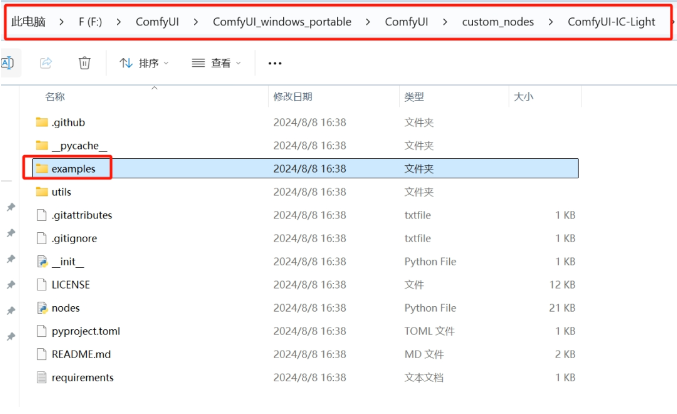

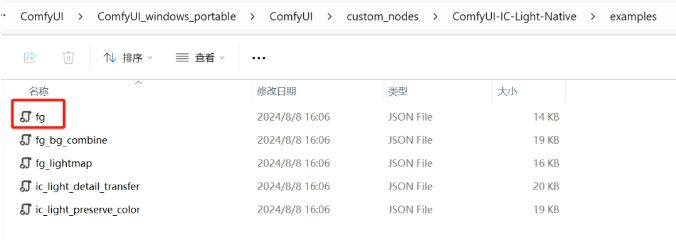

根据页面提示下载重启后来到ComfyUI的根目录可以发现有刚好下载好的两个文件夹。

点开任意一个后里面有一些example,这些就是可以直接拖拽进ComfyUI中的工作流。

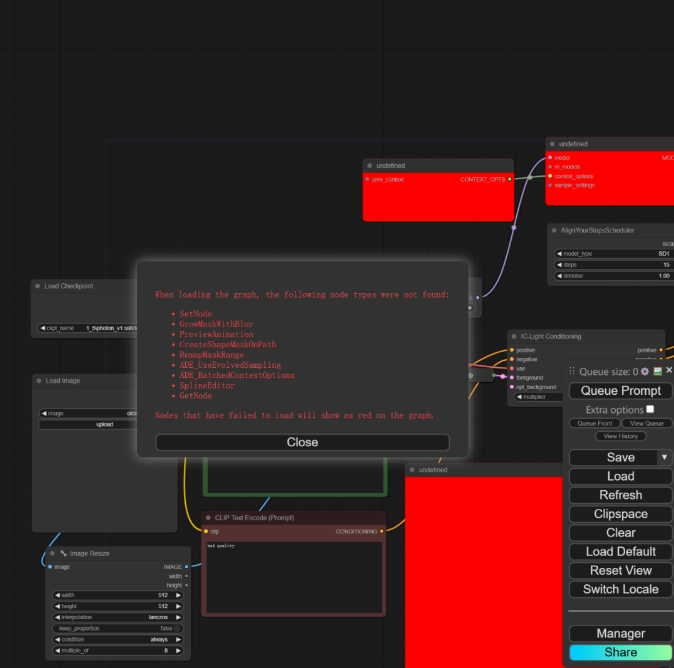

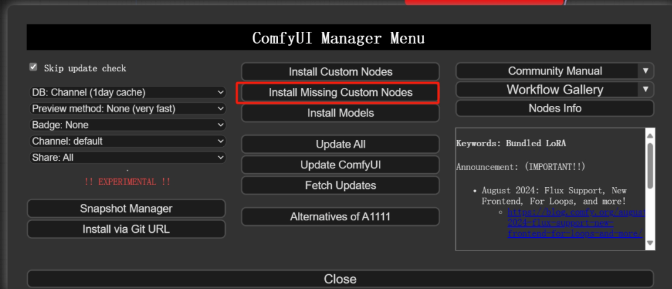

在工作流拖拽到ComfyUI中可以看到有些缺失的地方,这里直接去Manager中寻找缺失节点即可。

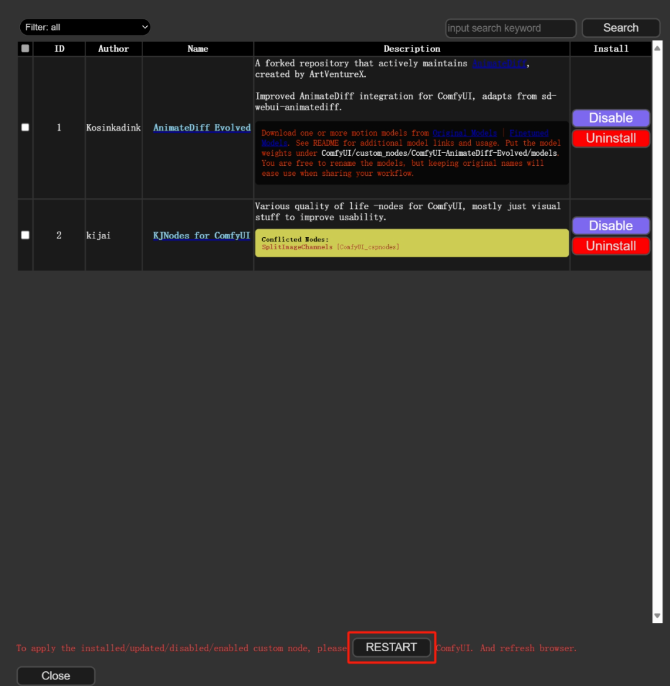

在下载完之后会有提示,直接点击最下方的重启即可。

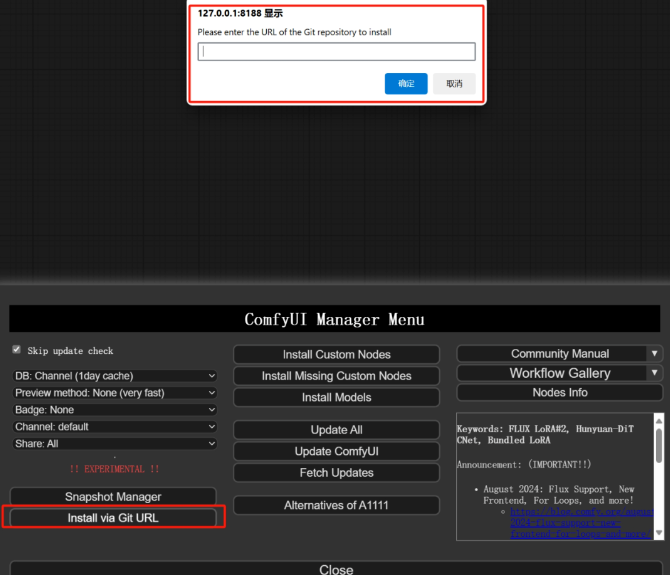

如果有些nodes提示下载失败,则可用URL下载的方法,操作也很简单:

点击这个页面会跳转到该nodes的github仓库,然后将仓库的网址复制粘贴到这个提示框中:

之后再点击重启即可。

IC-Light的操作

在ComfyUI中的操作其实和前面两篇笔记中的操作是大差不差的:

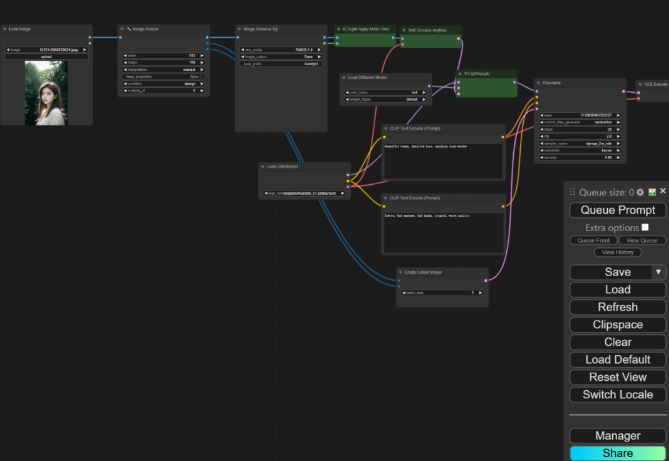

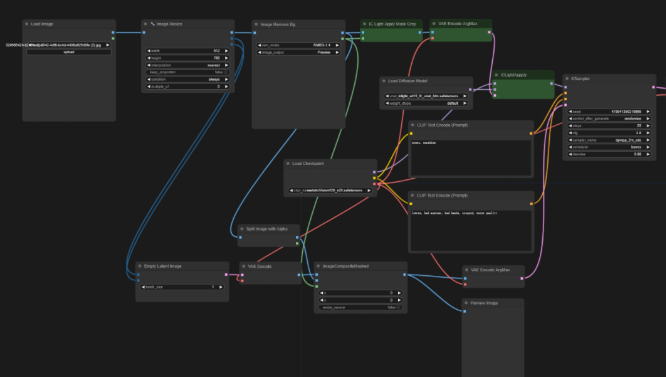

这里我导入的是上面下载的节点包中的工作流:

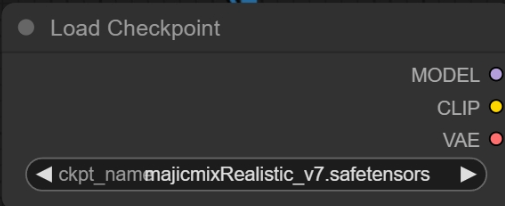

使用这个工作流要注意的就是加载模型的这个节点记得选用和导入的图片风格类似的大模型,二次元就选二次元,真人风格就选真人风格。

这样调整完之后就可以使用啦!

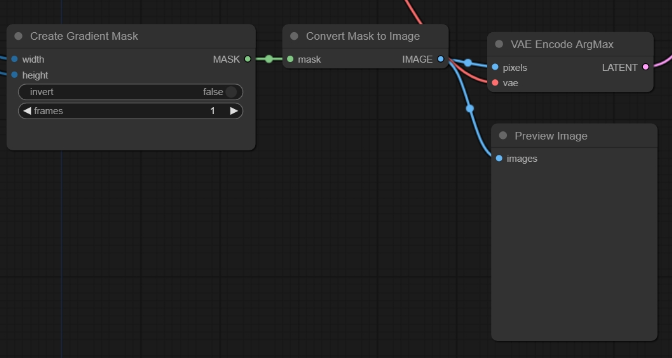

除此之外开发者也提供了三种不同的进阶工作流,其中有一个工作流标有lightmap,这个节点可以用来生成光线贴图。

所谓的光线贴图就是像上一篇笔记中讲的控制AI生成光照的区域,但是这个默认节点只能生成左侧和右侧的光照。意思就是当AI生成图之后,太阳光等光影效果只会出现在画面的左侧或者右侧。

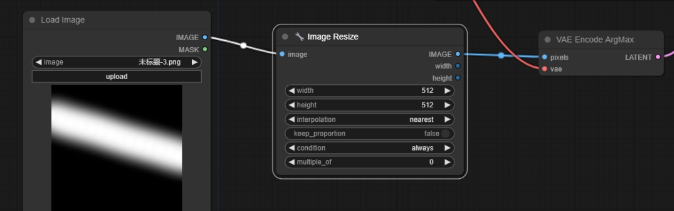

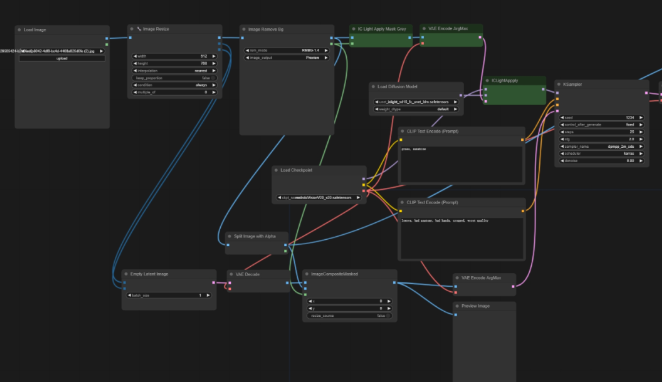

如果要和之前的笔记一样可以自由控制光线的话,那可以额外加一个Load Image节点。并且为了保证光线贴图能够贴合上传图片的尺寸,还需要再加一个image rezise的节点。

如果在运行的过程中这个节点出现了问题:

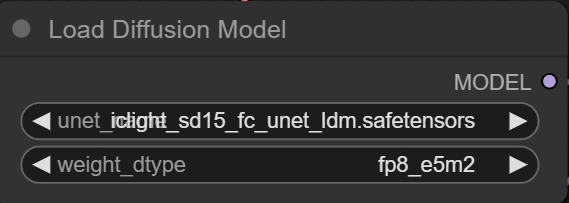

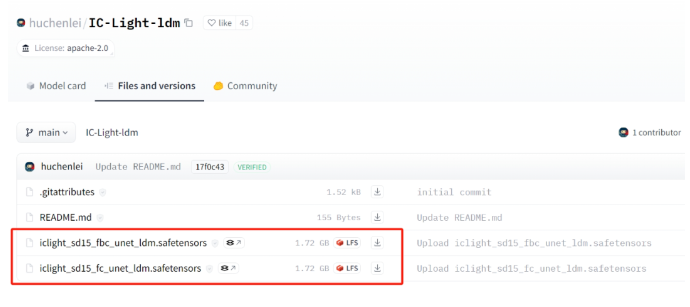

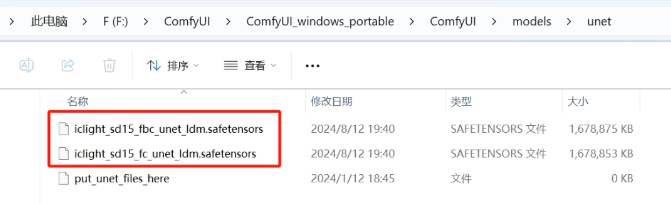

解决方法也很简单,来到根目录中名为unet的文件夹中,然后将在Hugging face下载的两个文件放在这里。

https://huggingface.co/huchenlei/IC-Light-ldm/tree/main

在Load Diffusion Model的unet_name选项那里选择fc_unet的这个选项。

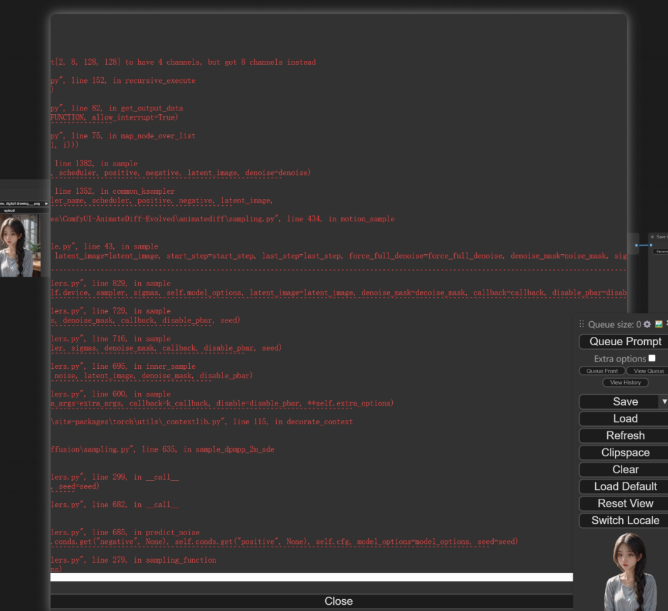

当然,可能会有小伙伴遇到这个问题,是Ksampler节点出现了问题:

这个问题困扰了我两天,我已经去发帖子询问了,如果有解决方法后续我会再进行补充的。

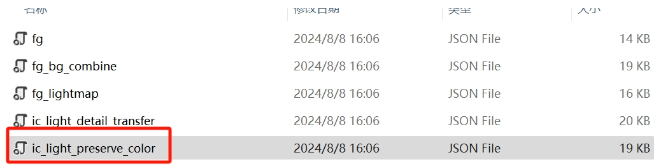

而另外两个节点也有一些优化措施,例如这个名为preserve_color(颜色保留)的节点

通过在生成Latent图像的时候部分置入主体区域像素,来做到更好地保持主体颜色,比较适合在采样过程中主体产生了较大色差时使用。

另一个Detailed_transfer(细节迁移)

则是在最终输出环节前加入了一层图像处理节点,让主体上的部分高频细节得到了保留。

IC-Light的出现一定程度上帮助了很多摄影后期甚至是电商的小伙伴,目前市面上已经有不少基于IC-light开发的AI摄影、电商出图等的工作流。

当然,以后还会有越来越多更加成熟的技术出现,我也在期待着那一天的到来。

川公网安备 123456789号

川公网安备 123456789号