微软发布VASA-1框架:实时生成逼真音频驱动说话面孔

近日,微软亚洲研究院公开了一篇名为《VASA-1: Lifelike Audio-Driven Talking Faces Generated in Real Time》的技术文章,该文章详细介绍了一个名为VASA-1的先进框架。VASA-1框架的核心理念在于,通过结合一张静态图像和语音音频剪辑,能够实时生成高度逼真的虚拟角色说话面孔,这些面孔具备生动的视觉情感技能。之前,我们也曾报道过腾讯的数字人音频技术,其生成的动画质量同样出色,相关详情可查阅:腾讯AniPortrait:通过音频和参考肖像生成高质量动画。

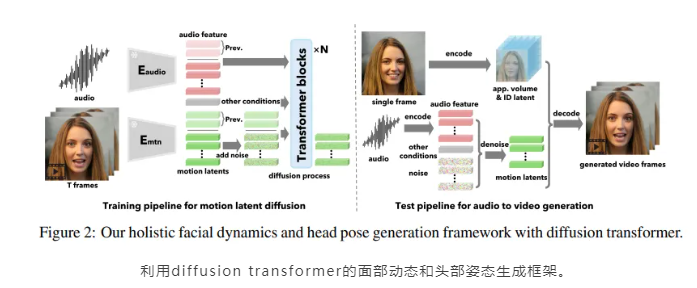

微软研发的VASA-1框架在实时生成与音频精确同步的唇部动作方面表现出色,同时,它还能细腻捕捉面部细节和自然的头部运动,使得虚拟角色的表现更为真实且富有生动性。这一框架的核心创新之处在于其构建了一个全面的脸部动态和头部运动生成模型。该模型在面部潜在空间内运作,通过视频开发,成功构建了一个表现力丰富且解耦的面部潜在空间。

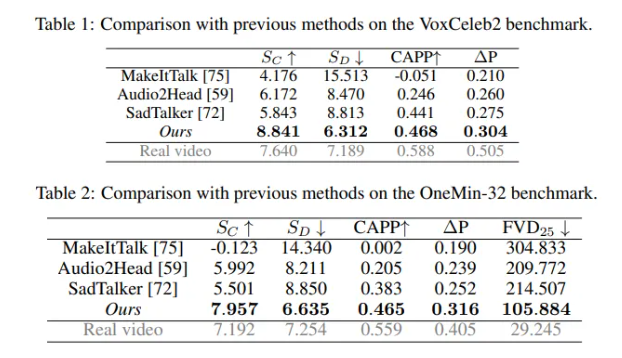

研究团队经过一系列广泛的实验和新指标的性能评估,证明VASA-1在多个关键维度上都超越了以往的同类技术。它不仅能生成高质量的视频,还能展现逼真的面部和头部动态。VASA-1支持在线生成高达40 FPS的512x512分辨率视频,且启动延迟极低。

关于VASA-1的架构,其并非直接生成视频帧,而是在潜在空间中生成全面的面部动态和头部运动。这些动态和运动是基于音频和其他信号的条件而生成的。给定这些运动潜在代码,VASA-1通过面部解码器产生视频帧,解码器还结合了从输入图像中提取的外观和身份特征。为了实现这一功能,VASA-1首先构建了一个面部潜在空间,并训练了面部编码器和解码器。此外,一个富有表现力且解耦的面部潜在学习框架被设计并训练在真实面部视频上。接着,VASA-1采用了一个简单但功能强大的扩散变换器(Diffusion Transformer)来模拟运动。该框架利用Diffusion扩散模型进行音频条件下的HFDG,并在大量来自不同身份的说话面部视频上进行训练。同时,VASA-1还巧妙地应用了Transformer架构来处理序列生成任务。

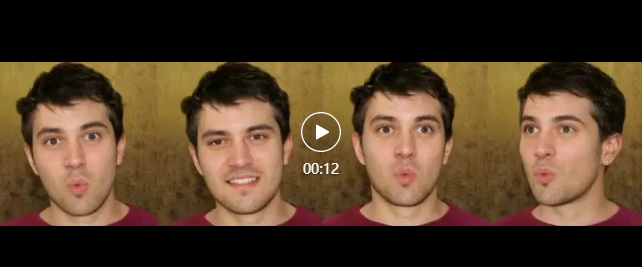

值得一提的是,VASA-1官方还展示了其演示案例。这些案例充分展现了VASA-1框架方法的真实感和生动性。它不仅能生成高质量的唇音同步效果,还能呈现出一系列富有表现力的面部细节和自然的头部动作。无论是处理任意长度的音频,还是输出无缝的说话面孔视频,VASA-1都能稳定地完成任务。

此外,VASA-1框架方法还具有出色的生成可控性。其扩散模型可以接受多种可选信号作为条件,如眼神注视方向、头部距离以及情感偏移等。这使得用户能够根据不同的需求,灵活调整生成结果。

在训练分布之外的泛化方面,VASA-1同样展现出了强大的能力。它可以处理训练集中未曾出现的数据类型,如艺术照片、歌唱音频和非英语语音等。这一特点使得VASA-1具有更广泛的应用前景。

此外,VASA-1还具备解耦的能力。其潜在表示成功分离了外观、3D头部姿势和面部动态,使得用户可以对生成的内容进行单独的属性控制和编辑。这为用户提供了更多的创作空间,可以根据需要对生成的面孔进行个性化的调整。

在实时效率方面,VASA-1也表现出色。在离线批处理模式下,它能够以45fps的速度生成512x512大小的视频帧;而在在线流媒体模式下,它也能支持高达40fps的生成速度,仅需170ms的前置延迟。这一高效的性能使得VASA-1在实际应用中具有更高的实用价值。

总的来说,微软亚洲研究院推出的VASA-1框架在实时生成逼真虚拟角色说话面孔方面取得了显著的成果。它不仅具备高质量的视频生成能力,还拥有丰富的面部和头部动态表现。同时,其出色的可控性、泛化能力和解耦能力使得VASA-1具有广泛的应用前景和巨大的市场潜力。

川公网安备 123456789号

川公网安备 123456789号