搏一搏单车变摩托!挑战GPT-4o,Meta首发「变色龙」大模型

GPT-4o发布仅数日后,Meta团队迅速崭露头角,推出了名为“Chameleon”的混合模态模型,这一新模型在单一神经网络中实现了对文本和图像的无缝处理。这款经过10万亿token训练的34B参数模型,其性能直逼GPT-4V,刷新了当前多模态处理领域的SOTA(最佳表现)。

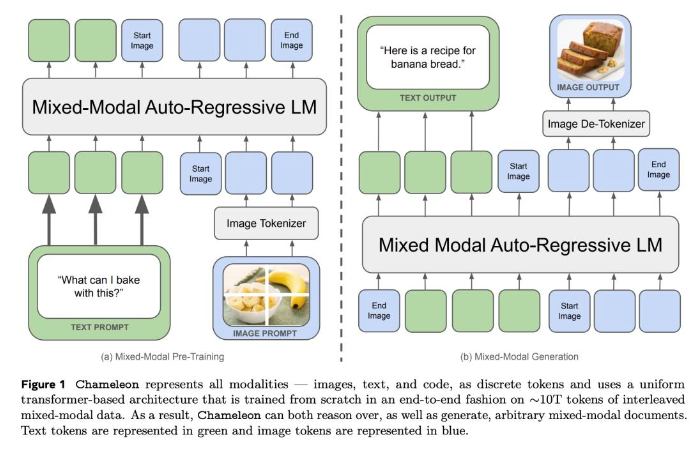

Chameleon与GPT-4o类似,采用了统一的Transformer架构,将文本、图像和代码等混合模态融入其训练过程。通过类似文本生成的方式,对图像进行离散化的“分词化”处理,从而生成和推理出交错的文本和图像序列。这种“早期融合”的方法让Chameleon从训练之初就将所有模态映射到一个共同的表示空间,从而实现了对文本和图像的无缝处理。

尽管Chameleon在发布之初就取得了令人瞩目的成绩,但业界专家普遍认为,这仅仅是对新一代“原生”端到端多模态基础模型的早期探索。Chameleon目前主要支持图像文本的生成,尚未涵盖GPT-4o所具备的语音能力。不过,正如一些网友所提到的,通过添加新的模态(如音频)并扩大训练数据集,Chameleon有望在未来进一步接近甚至超越GPT-4o的性能。

Meta的产品管理总监在Chameleon发布之际表示:“我非常自豪能够给予这个团队支持。我们正在朝着让GPT-4o更接近开源社区的方向迈进。”这一表态似乎预示着Meta未来可能会开放更多关于Chameleon的技术细节和源代码,推动多模态处理技术的发展和应用。

在技术细节方面,Chameleon采用了创新的模型架构和训练技巧。它通过将所有模态的信息映射到同一个向量空间,并利用统一的Transformer架构进行处理,实现了对文本和图像的无缝处理。此外,为了解决优化稳定性和模型扩展性方面的挑战,Chameleon采用了QK归一化和Zloss等训练技巧,并通过将纯文本LLM微调为多模态模型的方法来提高其性能。

在图像“分词器”方面,Chameleon的团队开发了一种基于大小为8192的codebook的图像分词器,将规格为512×512的图像编码为1024个离散的token。同时,该模型还采用了一个同时含有65536个文本token与8192个图像token的BPE分词器来处理文本数据。

在预训练阶段,Chameleon采用了两个阶段的训练方法。第一阶段让模型以无监督的方式学习纯文本、文本-图像对以及文本和图像交错出现的数据。第二阶段则在第一阶段的基础上,通过降低权重并混合更高质量的数据来进一步提高模型的性能。这种训练方法使得Chameleon能够充分利用不同模态的数据信息,并提高其跨模态信息处理能力。

尽管Chameleon在发布之初就取得了令人瞩目的成绩,但Meta团队并没有停下脚步。他们将继续探索多模态处理技术的边界,并推动其在各个领域的应用和发展。未来,我们有望看到更多基于Chameleon技术的创新应用出现,为人们的生活带来更多便利和乐趣。

川公网安备 123456789号

川公网安备 123456789号